安装spark需要先安装jdk;在安装jdk的时候,碰到了一些环境变量设置的问题。(入门级文章,适合小白看,大神绕道。)

注意jdk,Scala,spark之间有版本对应关系,百度一下就能查到。

这里采用的安装顺序和版本如下(2020年08月03日)anaconda(自带Python3、jupyter)——jdk1.8——Scala2.12——Hadoop3.2——spark3.0——pyspark——

下文的安装参考链接中有一些不正确的环境变量配置。现纠正如下:

JAVA_HOME和CLASSPATH按照博客中的教程来就可以。但是path的配置,只需要粘贴两个地址就可以,不用那么麻烦。

完整的安装教程如下:

安装jdk

http://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html

这里的Java se 8就是jdk1.8版本,不要慌。

让你注册账号就乖乖注册,记住密码什么的就行了。

不能默认路径安装!!!

期间会选择两次文件夹,都是默认路径。——但是!!!后续用到的时候,不允许路径里面有空格!!!太坑了,还要卸载重装,大家一定要在这里注意!!!

注意

切记

自己选择文件夹,比如想安装到d盘,那么需要新建一个总文件夹“Java”,然后两次选择,分别在Java文件夹中新建jdk1.8.0_231;在Java中新建jre1.8.0_231,两此安装分别 新建并选择 两个安装文件夹。

其原因是,安装jdk不仅仅是安装jdk,还要安装jre,两个都选在Java文件夹下,会发生文件覆盖。

配置环境变量

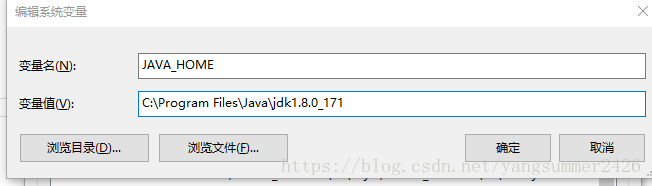

按照下图先配置一波

新建系统变量

变量名——JAVA_HOME

变量值——D:\programs\Java\jdk1.8.0_261

新建系统变量

变量名——CLASSPATH

变量值——.;%JAVA_HOME%\lib\dt.jar;%JAVA_HOME%\lib\tools.jar

注意最前面有个英文的句点

打开系统变量中的‘path’

新建

输入,%JAVA_HOME%\bin

打开系统变量中的‘path’

1新建

输入以下jdk的路径

D:\programs\Java\jdk1.8.0_261

2新建

输入以下jre的路径

D:\programs\Java\jre1.8.0_261

如果是自己选的安装路径,原样粘贴两个地址过来。

测试配置是否正确

cmd命令行

输入java -version

再输入javac -version

两次得到的版本应该一致。

安装Scala

下载地址官方http://www.scala-lang.org

下载历史版本https://www.scala-lang.org/download/all.html

默认地址安装

配置环境变量

SCALA_HOME——C:\Program Files (x86)\scala

配置path中添加两条

1——C:\Program Files (x86)\scala\bin

2——%SCALA_HOME%\bin

cmd命令行下输入Scala运行即可验证是否安装成功。

安装Hadoop

3.2版本的下载链接

http://mirrors.ibiblio.org/apache/hadoop/common/hadoop-3.2.1/hadoop-3.2.1.tar.gz

解压

配置hadoop_home和path

hadoop配置,参考该链接——https://my.oschina.net/zengfr/blog/3109119

①修改D:\programs\hadoop\hadoop-3.2.1\etc\hadoop目录下hadoop-env.cmd文件

将其中set JAVA_HOME=%JAVA_HOME%

修改为set JAVA_HOME=D:\programs\Java\jdk1.8.0_261

②我没做这步——https://github.com/cdarlint/winutils

在该处下载对应的winutils替换hadoop的bin文件夹

③打开cmd命令窗口,运行命令:hadoop version

即可成功运行

安装spark

spark3.0.0的下载链接

https://archive.apache.org/dist/spark/spark-3.0.0/spark-3.0.0-bin-hadoop3.2.tgz

完结撒花

参考链接:

文章1