torch.nn.Conv2d(in_channels, out_channels, kernel_size, stride=1, padding=0, dilation=1, groups=1, bias=True, padding_mode=‘zeros’)

卷积核与原图按照左上角对齐的原则进行卷积操作

stride:步幅,卷积核两次卷积左上角点之间的距离;通俗讲就是卷积核每隔几个像素进行一次卷积操作;stride默认值为1,可以以一个整数的形式或者元组的形式给出,以一个整数给出的时候,默认高和宽上的stride相同,以一个元组给出时,高宽的stride可以设置为不同值;

padding:=0时,不填充,原图与卷积核进行卷积;=1时,在原图四边填充一行(一列),具体填充的数据由padding_mode控制,一般填0)

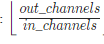

dilation:默认值为1,扩充卷积;指的是卷积核元素之间的距离,默认为1时,卷积前后图片尺寸计算公式:

代入就是平常常用的

O=(I+2p-f)/s+1