训练策略基本上对于每一个深度学习方法来说都很重要,选用到好的优化器或者学习策略可以使得我们的模型更快的收敛到最优值,比较常见需要调节的有如下:

1、学习率(Learning rate)

在ReID中BoT把学习率设置为3.5xle-4,之后很多工作都沿用了这个学习率,一个好的学习率可以有助于我们收敛,当然对于不同的数据集来说,学习率的设定是不同的,要在一定范围进行调节。

关于学习率可以参考以下文章:https://zhuanlan.zhihu.com/p/41681558

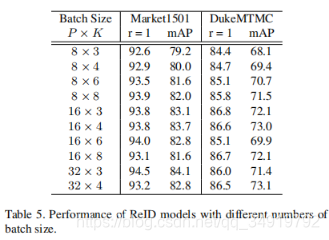

2、Batch Size

ReID中的Batch Size设置与其他的深度学习任务有一些区别,它涉及到两个参数P(一个batch中涉及到的不同类别的样本数量)和K(一个batch中涉及到的同一个类别的样本的样本数量)。在BoT的工作中,对Batch Size的大小和P、K的设置做了探究,实验如下表,不同的数值对最终的实验结果还是有很大的影响的。

3、Warm up

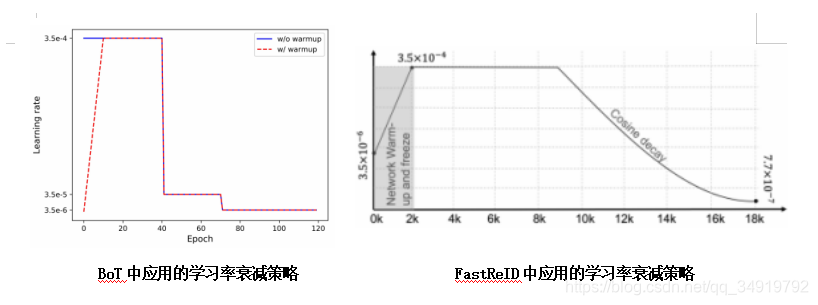

Warm up的提出思路立足于作者认为在minbatch学习中,一开始的方差很大,学习到的权重很不稳定,这会导致模型学习剧烈波动。虽然使用0.01来学习最后会收敛,但是收敛到的点并不是最好的点,而使用了Warm up策略可以使得一开始学习率小,学习波动小,可以收敛到更好的收敛点。个人觉得是一些权重在一开始大的学习率下进行学习,造成了大的波动,学偏了,在后面如何调节都很难再调节回来了,而Warm up在初始的时候可以对模型的权重进行小学习率的微调,不会有剧烈波动,有利于之后的学习,这也造成了用Warm up策略学习到了效果普遍较好一些。

关于Warm up可以参考以下文章:https://www.zhihu.com/question/338066667

4、Lr scheduler

Lr scheduler在pytorch中集成了六种方法,可以在torch.optim.lr_scheduler中调用,主要分为三大类:

1)有序调整:等间隔调整(Step),按需调整学习率(MultiStep),指数衰减调整(Exponential)和余弦退火CosineAnnealing。

2)自适应调整:自适应调整学习率 ReduceLROnPlateau。

3)自定义调整:自定义调整学习率 LambdaLR。

好的学习率的衰减策略选择可以帮助模型收敛到最优值。

关于学习率方法的参考链接:https://blog.csdn.net/zisuina_2/article/details/103258573

5、Backbone freeze

在ReID任务中,通常会选择一个在ImageNet上预训练过的模型来作为Backbone,如ResNet,并根据任务在后面添加相应的分类器,随机初始化分类器参数。为了更好地初始化分类器的参数,在训练开始时冻结网络参数而不更新(2k迭代),只进行训练分类器参数。而在经过2k迭代后,将冻结解除,训练包括Backbone的整体模型,个人觉得这样做的目的是在Warm up阶段可以让分类器权重调节到一个比较好的位置,而不会因为分类器随机初始化的参数让Backbone中的权重学偏。