摘要

本文旨在深入研究卷积神经网络的特性,以及一种改进cnn结构性能的通用方法。具体而言,论文检查现有的cnn模型,并观察到一个有趣的性质,即低层中的滤波器形成对(即相反相位的滤波器)。在我们的观察的启发下,我们提出了一种新的、简单而有效的激活方案-CReLU,并从理论上分析了它在CNN中的重构性质。我们将Crelu集成到几个最先进的cnn架构中,并在CIFAR-10/100和ImageNet数据集上展示了它们在训练参数较少的情况下的识别性能。我们的结果表明更好的理解CNN的特性,有助于我们更好的提升神经网络的性能。

引言

虽然当前提出一系列提升神经网络的性能或使神经网络更容易训练的方法,但是对CNNs的理解仍然非常落后。为了解决这一问题,本文旨在提供关于卷积神经网络内在性质的理解。

为了更好地理解CNN的内部操作,我们研究了著名的Alexnet,然后发现网络为前几个卷积层学习高度负相关的滤波器对。根据我们的初步发现,我们假设Alexnet的下卷积层学习冗余滤波器来提取输入信号的正负相位信息(第2.1节)。基于我们猜想的前提,我们提出了一种新的、简单而有效的激活方案-CReLU。所提出的激活方案既保留了正相位信息,又保留了负相位信息,同时实现了非饱和非线性。Crelu的独特性质使得卷积层在重构特性上具有数学特性,这是一个重要的指标,说明了相应的CNN特征是如何表达和可概括的(2.2节)

在实验方面,与ReLU和AVE在CIFAR-10/100和ImageNet数据库上进行对比。我们证明,在现有最先进的cnn体系结构的较低卷积层上将CReLU替换原ReLU可以显著提高分类性能。此外,在适当应用的情况下,CRLU可以在不牺牲分类性能的情况下实现显著的参数缩减。

我们从正则化(4.1节)和不变表示学习(4.2节)等几个角度对实验结果进行了分析,回顾性地对CRLU模型的重构特性进行了实证评价,并证实了通过对CRLU的集成,原始的“卷积核成对出现”现象如预期的消失了(4.3节)。总之,我们的结果表明,通过对CNN的本质的更好的理解,只要对结构进行简单的修改,我们就能实现它们更高的性能。

Crelu与重建性质

卷积层的猜想

在使用AlexNet进行分类时,发现第一个卷积层中的卷积核所学习到的权重是成对出现的。更准确地说,假设每一个滤波器φi的单位长度向量,我们以下列方式定义了φi的配对滤波器: 同时也可以定义成对滤波器的余璇相似度:

同时也可以定义成对滤波器的余璇相似度:

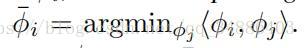

下图展示第一层卷积核成对出现的现象:

从实验结构发现一个有趣现象,对于每一个过滤器,确实存在另一个过滤器,几乎处于相反的阶段。

AlexNet采用了流行的非饱和激活函数-校正线性单元(Relu),其将负值归零并产生稀疏激活。因此,如果正相位和负相位沿特定方向参与表示输入空间,则网络需要学习这两个阶段的两个线性相关滤波器。

为了研究在更深层次中这个卷积核成对出现的现象,作者对AlexNet的1-5卷积层中的余弦相似度进行统计。

作为比较,我们生成了的随机高斯滤波器riri,并绘制了u???riu?ir(上标为r表示是随机生成的分布情况)的直方图。对于conv1层,观察到u???wiu?iw(上标为w表示训练后的情况)的分布是负中心,相反u???riu?ir的均值只有轻微的负值,标准偏差很小。然后,随着网络的深入,中心逐渐向零移动。这意味着较低层的卷积滤波器往往存在一个或几个与其相位相反的滤波器,而随着它们的加深,这种现象逐渐减少。

根据上述现象,经过在神经网络中使用ReLU激活函数消除负输入,在深度神经网络的前几个卷积层,他们通过学习构成“成对”的滤波器以捕获正负相位的信息。这个猜想意味着低卷积层的滤波器之间存在冗余。

事实上,对于一类非常特殊的深层结构,不变散射卷积网络,它的卷积核实wavelets型(不懂)。一方面,与relu类似,散射网络中的每个个体激活都保留了输入的部分信息。另一方面,与relu不同,但更类似于avr,散射网络激活保留了能量信息,即保持了响应的模数,但消除了相位信息(对这种网络不清楚),在一般CNN中,relu函数实际保留了正相位信息。

现在,假设我们可以利用配对先验知识,设计一种方法显式地允许正负两种激活,那么我们就可以减轻卷积滤波器之间由重线非线性引起的冗余,并更有效地利用可训练的参数。为此提出CReLU。

它简单地复制了卷积后的线性响应,对它们进行了否定,将激活的两个部分串联起来,然后完全应用了relu。它简单地复制了卷积后的线性响应,进行取反,然后两个合并成新的响应,然后一起。

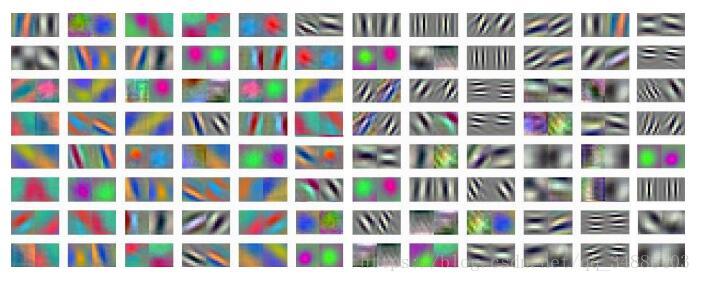

定义:

允许负激活的另一种方法是采用更广泛的非饱和激活函数,包括Leady relu及其变体。Leaky ReLU是在负值部分加入一个小斜率。这些激活函数与Crelu具有相似的动机,因为它们都解决了硬零阈值所引起的两个潜在问题:(1)卷积结果小于0,未激活,则不会作出调整。(2)截断所有负面信息可能会妨碍学习。然而,crelu是基于一个激活方案,而不是一个函数,它从根本上区别于Leaky ReLU或其他激活函数。在我们的版本中,我们将正负分离后的relu应用到Crelu中,但这并不是唯一可行的非线性。例如,crelu可以与其他激活函数(如Leady relu)相结合,为体系结构增加更多的多样性。

另一个自然的类比是在CRELU和AVR之间,后者只保留模量信息,而丢弃相位信息,类似于散射网络。

重构特性

Crelu的一个显著特点是它的信息保存性质:Crelu保留卷积后的负线性响应和正线性响应。信息保存的一个直接后果是使CRELU的卷积层具有重建能力。cnn的重构属性意味着它的特征代表输入数据。CNN的这一方面最近引起了人们的兴趣:Mahendran & Vedaldi

(2015) invert CNN features back to the input under simple natural image priors;(不懂,,,,),通过堆砌自编码器对物体进行重建能构建更好的分类器。Bruna et al. (2013) theoretically investigate general conditions under which the max-pooling layer followed by ReLU is injective and measure stability of the inverting process by computing the Lipschitz lower bound.(不懂)

基准测试

首先,通过简单地替换relu,同时保持卷积滤波器的数目不变,将crelu集成到基线模型中,使每个卷积层的输出信道数翻一番,模型参数的总数加倍。为了查看性能增益是否来自增加的模型容量,我们对基线模型进行了额外的实验,同时将滤波器和crelu的数目增加了一倍。在将滤波器数目减半的同时,我们还评估了AVR模型的性能,同时保持卷积滤波器的数目与基线模型相同。

在cifar10上面,CReLU好

具体内容略。。

讨论

在这一部分中,我们从网络的正则化和学习不变表示等几个方面讨论了Crelu激活方案的定性性质。

从正规化的角度看

模型参数越多越容易过拟合,而当前常用L2正则化防止过拟合,然而,相对于传统的CIFAR实验,CReLU的模型显示出的过度拟合问题要比使用relu的基线模型少得多,尽管它有两倍多的参数(表1)。我们认为,保持正和负的相位的信息会使训练的网络更具好,并利用这种效果更好地规范深层网络,特别是在处理小数据集时。

后面涉及到 Rademacher complexity bound 还不懂,之后再补充。

定理4.1指出,Crelu线性变换的复杂度界与relu线性变换的复杂度界相同,这是由wan等人证明的。换句话说,尽管模型参数的数量增加了一倍,但模型的复杂性并不一定会增加。

学习不变特征

我们使用古德费罗等人(2009)的评价指标来度量不变性分数,并对Crelu模型和relu模型进行了另一次比较。为了进行公平的评价,我们比较了所有7个Conv层的all-conv relu模型和那些在CIFAR-10/100上训练的all-conv crelu模型。在ImageNet实验中,我们选择了用crelu代替relu的前7个Conv层的模型,并从基线关系模型中比较了前7个Conv层与前7个Conv层的不变性得分。补充材料中的d节详细介绍了如何测量不变性分数。

下图分别绘制了在CIFAR-10、CIFAR-100和ImageNet上训练的网络的不变性分数。

Crelu模型的不变性分数始终高于relu模型。,在conv2与conv3,conv4与conv6之间有较大提升是因为使用max-pooling,它可以很好的提出移位不变性特征。我们还观察到,虽然总体趋势是,随着网络的深入,不变性分数也会增加。

这个有趣的观察表明cnn中不同层的潜在着不同的功能,这是值得研究的。

特别是ImageNet relu模型的分数在1、4和7层达到局部最大值。它启发我们设计在卷积1、4和7层之后放置crelu的体系结构,以鼓励不变性表示,同时将滤波器数目减半以限制模型容量。

重建特性

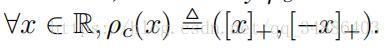

在2.1节中,我们观察到来自relu模型的低层卷积滤波器形成了负相关的对,对于crelu模型是否还存在配对现象?我们采用在ImageNet上训练的最好的Crelu模型(前4个Conv层与crelu集成),并重复直方图实验以生成图3。与图2形成鲜明对比的是,Crelu模型中的u???wiu?iw分布与随机高斯滤波器的u???riu?ir分布很好地吻合。

表明使用CReLU的卷积层没有成对卷积核出现的现象。