摘要

受神经科学研究成果的启发下,论文引入并定义了两种具有不同激活功能的人工神经网络神经元:兴奋性神经元和抑制性神经元,其网络可以通过学习,自适应地选择不同种类的神经元函数。论文在神经元定义(生物角度上定义)的基础上,不仅探讨了主流激活函数,而且还讨论了这些类型神经元之间的互补性。

此外,通过兴奋性神经元与抑制性神经元的共同作用,论文提出一种组合激活函数。

最后,论文希望能为未来的神经元激活函数设计提出一个指导方向,同时为生物学与计算机科学之间搭建桥梁,使得能从生物的角度解析当前的神经网络。

引言

有很多方法可以提升CNN的性能,粗略可以分别构建更深网络结构,改变非线性激活函数,预防过拟合技术。

在这些技术中ReLU激活函数的发明是深层神经网络得以成功的关键。它加速了学习过程,并减缓深层网络训练中的消失/爆炸梯度问题。

所以激活函数的重要性不言而喻,许多研究者提出了完善的激活函数来提高网络性能。

这些相似的工作大致可以分成两类:

1、修正ReLUs(如 Leaky ReLU,PReLU,Random ReLU(RReLU),ELU,PELU,MPELU),他们移除了负输入中零梯度

2、集成激活函数(例如,maxout[Goodfreer等人,2013年],自适应分段线性(APL)[Agostinelli等人,2014年],NIN[Lin等人,2013年],S-shape relu(Srelu)[jin等人,2015年],Concatenated relu(Crelu)

尽管激活功能普遍存在,但很少有人从神经证据的角度来关注它们的共同特性。在神经科学领域,大脑皮层有两种主要类型的神经元(即大脑表面):primary neuron为兴奋性神经元,relay neuron为抑制性神经元。在正常情况下,两种细胞相互调节,使大脑处于兴奋和抑制状态的动态平衡。

因此,在神经学知识的启发下,本文提出了两种具有不同激活功能的人工神经网络神经元:兴奋性神经元和抑制性神经元,用于神经元类型的选择。

在这些神经元的基础上,我们不仅统一分析了主流的激活函数,而且从神经科学的角度讨论了这些神经元类型之间的互补性。此外,通过兴奋性和抑制性神经元的协同作用,结果表明,所提出的激活函数对神经网络的训练有很好的效果,并在多个图像识别基准上达到了最先进的性能。

相关工作

1、整流单元家族

由于激活函数会带来非线性,因此在深层神经网络中起着重要的作用,因为它们对整个系统的性能有着重要的影响。ReLU的出现减少了爆炸/消失梯度问题,加快了收敛速度。与ReLU相比,LReLU,PReLU和RReLU在激活单元中加入了一个负输入的正斜率参数,以消除零梯度。它们在斜率参数的获取方法上各不相同,其中LReLU是在训练过程之前预先定义的,PReLU是自适应学习的,RReLU是在训练过程中基于随机正则化的随机采样。Elu被定义为正输入原样输出而负输入则为exp(X)?1,它通过接近零的平均激活量来处理方差较大和偏差漂移问题。与PELU,MPELU相似,为ELU负部分引入了一个非零斜率参数,并提出了ELU序列的权值初始化策略。PELU在正/负部分引入了几个斜率参数,并在训练中通过修改在零附近的可微性从而使得这些参数能在反向传播中调整。

2、集成激活函数家族

集合激活函数在理论上对任何光滑函数都具有强大的近似能力。maxout使用maxout激活单元在几个经过几个可以学习的转换函数后可以输出最大值(对这个maxout不懂。。。)自适应分段线性(APL)是一种参数化铰链形状函数的加权和,其参数是在训练过程中学习的。NIN用多层感知器逼近卷积网络中的非线性整流激活函数,其中参数从数据中学习。S形校正线性激活单元(Srelu)构造了三个具有四个可学习参数的分段线性函数,可以模拟心理物理学和神经科学中的复杂凸函数和非凸函数。利用低层反相滤波器的观测特性,通过对卷积层输出值的相同拷贝,将新拷贝得到的取反,将负部分和原部分连在一起,然后再使用ReLU激活,这就是CReLU。

兴奋和抑制神经元激活函数

在这一部分中,给出了人工神经网络中兴奋性神经元和抑制性神经元的定义,然后提出了这两个神经元的组成激活函数。最后,讨论了主流激活函数之间的内在联系,并给出了一些解释。

两种神经元类别

受神经科学的启发,我们可以为人工神经网络定义两种类型的神经元,并不是每个信号对人类决策中的特定任务都有用,因此,存在两种不同的神经元。第一个是“兴奋性神经元”,它是一个很好地保存输入信号的函数;第二个是抑制性神经元,它可以抑制输入信号。这样,神经网络就可以根据任务的要求,以数据驱动的方式动态地选择信号。在以往的研究中,应用最广泛的神经元是兴奋性神经元,而抑制性神经元在文献中的研究并不是很好,本文将说明这两种类型的神经元对于神经网络都是重要的和互补的。

实际上,兴奋性和抑制性神经元可以用许多不同的形式来定义。文中对这些神经元的定义给出直观的解释。

兴奋性神经元:

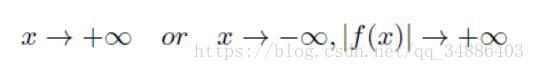

这意味着在某些条件下,输出f(X)保持输入x的绝对值而不受抑制。对于兴奋性神经元,最简单的线性激活函数是f(x)=x。然而,它不能使人工神经网络具有非线性映射的能力。为了更好地拟合非线性数据,最简单的非线性激活函数是f(X)=max(x;0),即ReLU。

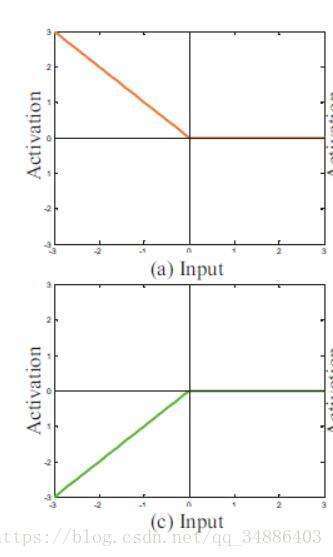

以下图示的都是兴奋性神经元激活函数:

抑制性神经元

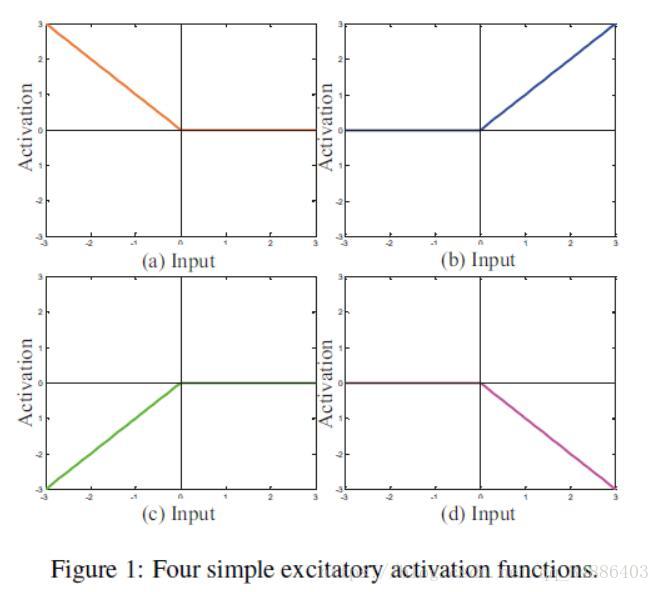

不仅兴奋神经元重要,抑制神经元在神经网络中起着关键作用。对于抑制性神经元,一个神经网络可以通过抑制不同层次的神经元反应来保持平衡。

其定义:

这意味着,即使输入信号x的绝对值趋于无穷大,抑制神经元f(X)的输出不超过“常数”或趋于稳定。

四种常见的抑制性神经元:

兴奋性和抑制性神经元的组合

兴奋性神经元保留输入信号,抑制神经元抑制信号,在神经网络中起着不同的作用。兴奋性神经元和抑制性神经元之间有三种最可能的组成:(1)兴奋性和兴奋性神经元;(2)兴奋性和抑制性神经元;(3)抑制性和抑制性神经元。

兴奋性与兴奋性神经元的组合

CReLU是一种典型的兴奋性与兴奋性神经元的组合。同时,兴奋性神经元的组合方法也有所不同,不是随意两个兴奋性神经元的组合就能取得很好的效果。如何它们是独立的,那组合就能提升效果。如果它们是耦合关系(如下图所示),就会导致学习过程震荡。

耦合关系:

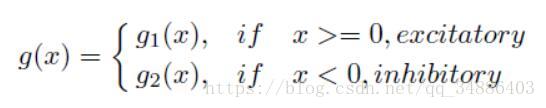

兴奋性和抑制性神经元

我们需要探讨兴奋性激活功能和抑制性激活功能之间的哪种成分具有最佳的互补性。在研究当前主流的修改神经元后,例如LReLU、PReLU、ELU和PELU,论文再通通过在正输出用f(x)=x,在负输入用f(x)=exp(x)-1的组合效果最好。

抑制性和抑制性神经元

比较常见就是Tanh

神经猜测

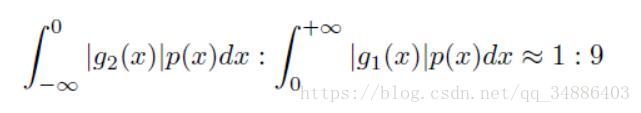

抑制性神经元在神经元总数中所占比例接近10%,而其他主要为兴奋性神经元。所以兴奋性神经元与抑制性神经元组合起来,他们对正负输出的激活情况要满足这个比例。当给定一个输入后,经过BN层,输出是服从一个正态分布。

根据兴奋性激活和抑制性激活的比率,我们推测存在如下表达:

其中∫是积分算子,x是绝对值,p(X)是概率密度函数。G1(X)=x和G2(X)=ax,a参数初始化为1/9。

为了使兴奋性神经元发挥主导作用,我们需要用自适应斜率惩罚抑制性神经元。

为了处理优化过程中的零梯度问题,maas等人提出了负输入对应的激活函数的非零斜率,它具有更强的鲁棒性。在PReL]、ELU和PELU的启发下,具有自适应学习的参数是一种很好的策略,可以降低人类干预措施的过度拟合风险,并减轻动态梯度传播。更多的惩罚减少了较小的负值输入的噪声效应,另外,自适应斜率也可以通过端到端网络训练来学习。

分象限假设:

深度神经网络具有稀疏性的许多优点(如信息分离、有效的变尺度表示、线性可分性和分布但稀疏),使用不同象限的函数可以更好的学习到信息。

神经学解释

我们将从三种情况介绍兴奋性和抑制性神经元的优点:1、只使用一种类型的兴奋性神经元

2、两种兴奋性神经元的协同作用

3、兴奋性和抑制性神经元的互补性

由于兴奋性神经元在神经科学中占据主导地位,在神经网络中,只有一种兴奋性神经元仍能很好地完成多种任务,例如最广泛使用的relu激活函数。

另一方面,有多种神经元可以构建不同的激活功能,例如,Crelu是两种兴奋性神经元的协同作用,其性能是令人满意的。

事实上,从神经网络的知识来看,神经网络中也有许多抑制神经元,虽然兴奋性神经元是非常重要的,但在不同神经元互补的高层次语义认知任务中,最好将抑制神经元加入到兴奋性神经元中。

因此,在接下来的实验中,我们提出了组分兴奋性和抑制性激活(EIA)功能,从而获得了更好的性能。

实验

在VGG上使用CIFAR-10、CIFAR-100

在AlexNet上使用ImageNet

单一种类神经元实验结果,大家都差不多,relu最好。

同时使用两种兴奋性神经元,发现使用级联结构的并行性更好,这是因为级联结构不仅利用了稀疏性的优势,而且还探索了由相位信息组成的独立象限之间的互补信息,同时发现EE-1-2, EE-1-3, EE-3-4的组合比EE-2-3 and EE-1-4好

使用一个兴奋性和一个抑制性神经元,实验表明EIA的效果最好,他对比EI1,3多了个自动学习的参数

分象限的假设的评估,使用分象限的方法,可以选着不同的神经元来构建激活函数,实验也表明级联的效果好,进一步的实验,兴奋性神经元用f(x)=x,抑制性神经元用f(x)=a(exp(x)-1),实验表明当a=0.11时,网络性能最佳,与之前兴奋性神经元与抑制性神经元比列9:1相符合

讨论

在这一节中,我们讨论了我们的发现与神经科学之间的关系。对于并行和分布式生物神经元,在有信号输入的情况下,神经元发放脉冲的情况对应着激活函数。生物激活功能由单向抑制、稀疏激活和反对称抑制或对称兴奋态组成。受生物知识的启发,文中提出EIA函数与上面的特征有关,分象限的假设似于单向抑制,而平行的级联结构则可以达到稀疏激活和抑制/兴奋状态。

结论

本文提出了两种具有不同激活功能的人工神经网络神经元:兴奋性神经元和抑制性神经元,借助不同类型的神经元,设计了兴奋性和抑制性激活函数,使网络更加稀疏,减轻了偏置漂移和梯度消失问题,综合实验不仅符合神经科学的研究成果,如兴奋性的重要性。而抑制神经元,同时也证明了所提出的方法已经达到了最先进的性能.

注意,这里的两类激活函数是同时使用,即同一输入,经过两个不同激活神经元,得到两个不同的输出,两个不同的输出都有稀疏性,因为他们的神经元都是单象限的。