Deep Knowledge Tracing and Dynamic Student Classification for Knowledge Tracing(译)

知识跟踪的深度知识跟踪和动态学生分类

摘要

在智能辅导系统(ITS)中,对学生在学习过程中的知识状态进行追踪的研究已经进行了数十年,以提供更多支持性的学习指导。在本文中,我们提出了一种新颖的知识追踪模型

i)捕获学生的学习能力,并以固定的时间间隔将学生动态分配给具有相似能力的不同群体, ii)并且将这些信息与称为深度知识追踪的递归神经网络体系结构相结合。实验结果证实,所提出的模型在预测学生表现方面比众所周知的用于学生建模的最新技术要好得多。

索引词-学生模型,深度知识跟踪,Kmeans聚类,RNNS,LSTM

I简介introduction

ITS是一个活跃的研究领域,旨在为学生提供个性化的指导。 早期工作可追溯到1970年代后期。各种各样的人工智能和知识表示技术已经发现,其中我们可以提到基于规则和贝叶斯的学生知识和误解表示,基于项目响应理论的逻辑回归的技能建模,基于案例的推理,以及最近强化学习和深度学习。甚至可以说,人工智能和数据挖掘中发现的大多数主要技术已进入ITS领域,尤其是在知识追踪问题上,目的是根据观察到的任务表现来模拟学生对概念或程序知识的掌握状态

在本文中,我们提出了一种新颖的知识跟踪模型,即具有动态学生分类的深度知识跟踪(DKT-DSC)。 在每个时间间隔,模型首先将一个学生分配到共享相似学习能力的不同学生群体中。 然后,此信息会被馈送到称为DKT架构[4]的递归神经网络(RNN),用于根据数据预测学生的表现。我们可以将学生分类视为对学生能力的长期记忆,因为RNN的输入可以改善DKT的知识追踪,这是最新的知识追踪方法之一。

本文的其余部分安排如下。 第二节是有关学生建模技术的相关工作的综述。 第三节介绍了建议的DKT-DSC模型。 第四部分描述了我们实验中使用的数据集。 实验结果显示在第五节中,最后第六节总结了本文并讨论了未来的研究途径

II相关工作

我们在这里回顾四种最先进的学生建模方法,用于评估学生的表现,无论是他们在心理计量学(IRT)或教育数据挖掘(BKT)中的优势,还是因为他们是表现最好的(PFA,DKT )。 参见[5]进行一般性回顾。

- 项目反应理论(IRT)

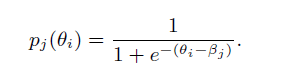

IRT假设学生的知识状态是静态的,并且在考试期间完成评估时以其熟练程度来表示[6],[7],[8],[9]。 IRT对单个技能进行建模,并假设测试项目是一维的。它为学生i分配静态能力θi。 每个项目j都有自己的难度βj。 IRT的主要思想是利用学生的能力和难度来估计学生i正确回答项目j的可能性。 广泛使用的IRT一个参数版本(称为Rasch模型)是

最近,Wilson [2016]提出了一种IRT模型,该模型优于最新的知识跟踪模型。 其中,使用牛顿-拉夫森方法计算θi和βj的最大后验(MAP)估计。

- BKT[位验苏1]

引入BKT是为了在学习环境中进行知识跟踪,对于该学习环境,静态知识状态的假设已被丢弃[3],[10]。 它还假设每个项目都测试了一项技能,但是此假设在以后的BKT工作中得到了放松。 学生对技能知识的标准BKT估计会不断更新,并包含以下四个概率:

- 绩效因素分析(PFA)

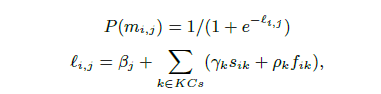

PFA是BKT的替代方案,它还放宽了静态知识假设,并以其基本结构同时对多种技能进行了建模[13]。 它定义学生i成功完成项目j的概率为:

- Deep Knowledge Tracing (DKT)

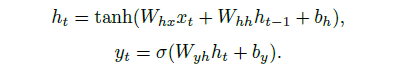

DKT是在[4]中引入的。 它使用长短期记忆(LSTM)[14]动态地表示学生的潜在知识空间。 通过作业,学生的知识增长可以通过利用学生以前的表现历史来推断。 DKT使用大量的人工神经元来表示潜在知识状态以及时间动态结构,并允许模型从数据中学习潜在知识状态。 它由以下等式定义:

III具有动态学生分类的深度知识跟踪

人类的学习是一个需要实践的过程:我们通过实践变得精通。 然而,学习也受到个人学习能力的影响,或者说通过或多或少的练习变得熟练。 我们把少练就精通的能力称为学习能力。 基于这一思想,我们提出了一种带动态学生分类的深度知识追踪模型(DKT-DSC),去评估学生的学习能力,并将其分配到具有相似能力的不同学生组中,然后模型调用RNN在不同的时间间隔跟踪她在每个不同组中的知识。 它可以根据学生的学习能力追踪他们的表现,并随着时间的推移定期重新评估。

A.学生学习能力的动态评估和分组

根据学生以往在学习系统中不同内容上的表现,将学生划分为学习能力相近的不同群体,已在教育领域的很多相关研究[15]、[16]中进行了探索,以便为每一类能力相近的学生提供更具适应性的指导。 基于对学生在下一个时间间隔开始之前的先前表现历史的评估,通过聚类来执行在每个时间间隔的学生学习能力的动态评估。

1)时间间隔:时间间隔是包含学生在系统中尝试回答问题的次数的段。 从这个角度来看,时间的流逝就是对一个问题或练习的一次首次尝试。

2)分割学生的尝试序列:将每个学生的响应序列分割成多个时间间隔有两个目的:1)减少长序列中用于学习的计算负担和存储空间分配。 2)在每个时间间隔后重新评估学生的学习能力,并动态地将其分配到下一个时间间隔所属的小组。

举例说明了将学生的24次尝试响应序列划分为5个段(时间间隔)的示例,其中一个段表示该学生回答系统中6个问题的时间间隔。 当学生停止与系统交互时,在最后的时间间隔中用-1表示。 每个学生尝试的次数根据他们在与系统交互期间回答的问题的数量而有所不同。

3)集群长期技能编码:学生根据他们的学习能力概况进行分组:他们获得的技能或知识。 评估学生学习能力的数据可以从以前对与特定技能相对应的测试项目或练习的尝试中获得。

学习能力档案被编码为具有技能数长度的向量,并在每个时间间隔之后通过使用每个技能的所有先前尝试进行更新。 将学生先前尝试的每种技能的成功率和失败率之间的差异转换为数据向量,以在时间间隔z上对学生i进行聚类,如下所示: 按时间间隔z将学生i聚类如下:

4)K-Means聚类:通过对数据D[17]、[18]进行K-Means聚类,在每个时间间隔将学生分配到具有相似能力的组中。 在聚类训练阶段,在不考虑时间间隔指标的情况下,找出每个学生组的质心。 一旦它被计算出来,在整个聚类过程中,每个组的质心将不再改变。 在此之后,我们在每个时间间隔将学生(在培训和测试数据中)分成不同的组(参见图2)。

当我们在时间间隔z找到学生i所属的组时,我们使用学习能力简档数据点di 1:z?1,因为我们不应该知道学生i在时间间隔z的当前尝试。在学习了所有K个聚类的质心之后,每个学生在每个时间间隔Seg都通过以下等式分配给最近的聚类

学生在互动过程中每个时间间隔(每个时间间隔包含20次尝试)的学习能力演变

图3展示了33名学生的学习能力数据,这些数据基于他们以前的表现和随时间间隔的演变。 深蓝色(-1)表示学生在退出系统时没有任何尝试。 组1用于每个学生的第一时间间隔,其余的组(2;::;5)通过使用先前的成绩数据di 1:z?1在每个时间间隔z由k-均值聚类方法分配。

B.深度知识追踪

DKT-DSC将学生的学习能力融入到DKT中,通过动态地将一个学生分配到一组能力相近的学生中,以更好地实现系统的个性化。 它放松了所有学生都有相同能力的假设,以及学生的能力随着时间的推移是一致的。 事实上,学生的能力是不断发展的,有些学生可能比其他学生学得更快。

在标准DKT中,xt是学生交互元组xt={st;at}的单热点编码向量,其表示所练习的技能st的组合,并且at指示答案是否正确。但是DKT-DSC还需要xt=fst;atg,另外还需要ct,其是指示Stui在当前时间间隔Segz的能力的组或簇簇(Stui;Segz)。 在隐含层中,将响应序列分割为多个时间间隔时,每个时间间隔的最后一个节点作为下一个时间间隔的第一个节点H0。 输出yt是一个长度与问题数相同的向量。因此,可以从yt获得在Segz的ct处正确回答下一个问题的概率。DKT和DKT-DSC的输出yt是相同的,这提供了特定问题的预测概率。

图4说明了DKT-DSC模型是如何通过在每个时间间隔(每个段)将学生的学习能力作为不同的组信息合并来改进知识追踪的个性化的。 输入层的每个时间间隔的颜色表示根据学生的学习能力在该时间间隔属于哪个组。 注意,在不考虑学生能力的情况下,DKTDSC模型与标准DKT模型是相同的。

图4说明了DKT-DSC模型是如何通过在每个时间间隔(每个段)将学生的学习能力作为不同的组信息合并来改进知识追踪的个性化的。 输入层的每个时间间隔的颜色表示根据学生的学习能力在该时间间隔属于哪个组。 注意,在不考虑学生能力的情况下,DKTDSC模型与标准DKT模型是相同的。

通过添加学生所属组的群集信息群集(Stui;Segz),我们确保这些高级统计数据仍然可用于模型在整个学年进行预测。这就是DKT模式所做的,对所有学生一视同仁,而不考虑他们的学习能力。 相反,DKT-DSC使用聚类的方法,利用学生在不同时间间隔的能力概况数据,找到一组能力相似的学生。 在不同的组别中追踪学生的知识可以更有效地预测学生的成绩。

最后,我们在表I中总结了本文各个模型的特点。

- 数据集

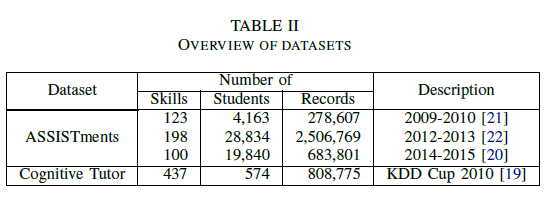

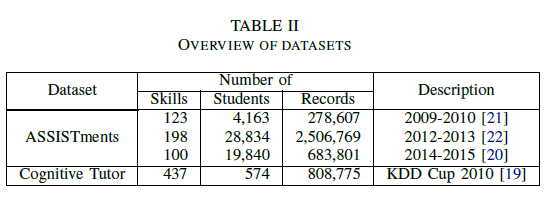

为了验证所提出的模型,我们在两个不同的辅导场景中的四个公共数据集上对其进行了测试,在这些场景中,学生在教育环境中与基于计算机的学习系统进行交互。

ASSISTment System2是一个在线辅导系统,最初创建于2004年,它让初中生和高中生在他们的数学问题上获得脚手架提示。 如果从事ASSISTments的学生正确回答了一个问题,他们就会得到一个新问题。 如果他们回答错误,他们会被提供一个小型的辅导课程,在这个课程中,他们必须回答几个问题,将问题分解成几个步骤。 数据集为:ASSISTments 2009-2010技能建造者数据集、ASSISTments 2012-2013、ASSISTments 2014-2015。

在所有数据集中,问题通常只有一种技能,但极少数可能与两种或三种技能相关联。 它通常取决于内容创建者给出的结构。 一些研究人员通过复制将具有多种技能的记录分成多个单一技能记录。 Wilson[6]声称这种类型的数据处理可以人为地显著提高预测结果,因为这些重复行可以占到DKT模型的Assistment09数据集中大约25%的记录。 因此,为了比较的公正性,我们在所有数据集中去掉了重复和多技能重复记录。

KDD Cup:PSLC DataShop发布了几个来自卡内基学习的认知辅导的数据集。代数2005-2006[19]是在KDD Cup 2010比赛期间发布的发展数据集3。 在此数据集中,问题与多项技能相关联。 因此,我们将多项技能的子集视为一项新技能[20]。

我们用来自两个独立的现实世界辅导的四个数据集来评估上述模型。 实验结果显示了模型在不同数据集上的性能。 在我们的实验中,只考虑了对原始问题的第一次正确尝试。

据我们所知,这些是最大的公开可用的知识跟踪数据集。

表II数据集数据集概览技能学生记录描

- 实验研究

DKT-DSC是从原来的DKT算法扩展而来,并与具有欧氏距离的k-Means聚类方法相结合。 在训练阶段进行了十次迭代。 DKT-DSC和DKT具有相同的损耗函数,每个隐层有200个全连接的隐藏节点。为了加快训练过程,使用小批量随机梯度下降来最大程度地减少损失函数。 我们实施的批量大小为32,对应于每个学生的32个拆分序列。 我们以0.01的学习率训练模型,并且还应用了dropout以避免过度拟合

在我们的实验中,使用了5次交叉验证来对这两个数据集进行预测。 每个次涉及在学生级别将每个数据集随机分为80%的训练数据和20%的测试数据。因此,培训和测试数据集都包含来自不同学生的响应记录。 仅使用来自训练数据集中的学生的数据来执行群集训练。 我们使用EM来训练BKT,并将迭代限制设置为200次。 我们学习每种技能的模型,并分别进行预测,然后对每种技能的结果进行平均。 对于DKT和DKT-DSC,我们将次数设置为100。 所有这些模型都是在相同的数据集上进行训练和测试的。 通过按时间顺序使用当前和先前的响应序列来预测学生的下一个响应。

我们将我们的模型与最先进的模型进行了比较:IRT[6],BKT[11],PFA[13],DKT[4]。 但我们没有与其他变体模型进行比较,因为它们或多或少是相似的,在性能上没有显示出显著的差异。

对于IRT,我们应用Knewton[6]中的代码,而DKT的代码来自WPI[20]。 对于DKT,我们使用与DKT-DSC相同的参数设置,并应用分段进行公平比较。 用曲线下面积(AUC)和均方根误差(RMSE)对每个模型预测的学生表现序列进行列表和评估。 AUC提供了一个健壮的度量,其中要预测的值是二进制的,就像我们的数据集一样。 AUC为0.50表示通过随机猜测获得的分数。 我们在实验中以BKT的AUC 0.61为基线。

在表III中,DKT-DSC在所有数据集中的性能都明显优于最先进的模型。 在ASSISTments09数据集上,与AUC为0.73的标准DKT相比,我们的DKT-DSC模型获得了0.92的AUC,相当于26%的显著增益。 在包含250万条记录的ASSISTments12数据集上,结果显示DKT-DSC的AUC比原始DKT的AUC增加了11%,AUC为0.80,而原始DKT的AUC为0.72。 在最新的ASSISTments14数据集中,DKT-DSC比原来的DKT提高了19%。 在认知辅导数据集中,DKT-DSC在AUC=0.81的情况下也获得了约1%的增益,而原始DKT的AUC=0.79。至于其他算法,IRT在所有数据集中也比原始DKT略有改进,但DKT-DSC的性能明显好于DKT和IRT。 请注意,原始ASSISTments14数据集中没有提供问题ID。 因此,我们使用技能ID作为IRT模型的问题ID,这就是为什么IRT只能获得0.67的AUC。 在上述所有模型中,只有IRT模型学习问题难度,而所有其他模型仅依赖技能。

在表IV中,当我们比较模型的RMSE均方根误差时,BKT在ASSISTments09中为0.46,在ASSISTments12中为0.51,在认知辅导中为0.47。 DKTDSC在所有数据集中的RMSE结果都在0.40以下,而所有其他模型的RMSE结果都不小于0.42(认知辅导数据集中的IRT、PFA和DKT除外)。 根据这些结果,DKTDSC在所有ASSISTments数据集上的表现都要好于所有ASSISTments数据集,并且在认知辅导数据集中表现出稍好的性能。 所有上述实验都是在包含20次尝试和8组(学生组)的时间间隔内进行的。

DKT-DSC具有不同长度的时间间隔数据集Ass09 Ass12 Ass15 KDD 20 0.91 0.81 0.86 0.81 30 0.88 0.80 0.82 0.81 50 0.87 0.80 0.78 0.81 100 0.82 0.77 0.73 0.82将学生的回答分割成固定的时间间隔,并在本实验中以每个包含20、30、50和100次尝试的时间间隔进行测试,得到DKT-DSC的表V AUC(在本实验中,每个时间间隔包含20、30、50和100次尝试)。 DKT-DSC的性能在表V中描述,当每个时间间隔包含具有574(联合)技能的KDD数据集中的100次尝试时,DKT-DSC的性能更好。 根据其中包含的技能数量,可以将其视为一个小数据集。 因此,由于数据的稀疏性,它可能会低效地识别学生所在的群体。 当它在每个时间间隔中包含足够数量的尝试时,它表现出更好的性能。

在DKT-DSC中(将学生分为4组)将学生的反应分为固定的时间间隔,并在此实验中测试每个时间间隔包含20、30、50和100次尝试。 表V中描述了DKT-DSC的性能。当每个时间间隔在具有574(联合)技能的KDD数据集中包含100次尝试时,DKT-DSC的性能会更好。 根据其中包含的技能数量,可以将其视为小型数据集。 因此,由于数据稀疏,它可能无法有效地识别学生的群体。 在每个时间间隔中包含足够数量的尝试时,它会显示出更好的性能。

除具有不同长度的时间间隔外,各种数量的群集还提供了不同的性能,如表VI所述。 根据实验结果,在每个时间间隔内尝试20次的8个群集是DKT-DSC的最佳参数。

VI 结论和未来的工作

在本文中,我们提出了一种新的模型DKT-DSC,该模型评估每个时间间隔的学生的学习能力,并动态地将学生分配给具有相同能力的不同学生群体。 根据每个时间间隔所属的组来跟踪学生的知识。使用四个数据集进行的实验表明,所提出的模型在统计上表现出色,并且明显优于最新模型。DKT假设所有学生都具有相同的学习能力,并且仅按技能顺序跟踪知识的提高,而不考虑每个学生的能力和学习率之间的差异。 相比之下,我们的模型通过捕获学生随时间推移的能力,相对于DKT有所改进。 通过这种方式评估学生的能力,可以在预测下一个时间间隔的学生表现时向模型提供关键信息,并在学生能力动态变化的地方追踪他们的知识。 我们通过考虑学生的能力和实践技能来个性化输入向量。 不仅可以单独使用技能水平,还可以将学生在分组信息方面的能力结合到DKT-DSC中,从而可以提高对成绩的预测。 在每个时间间隔动态评估学生的能力起着至关重要的作用,并有助于DKT-DSC模型捕获更多数据差异,从而得出更准确的预测。

在未来的工作中,我们将使该模型适应系统中具有多个关联子技能的问题,并将其应用于对具有多个关联技能的问题的建议中。 应该根据知识水平和学生所具备的能力来建议练习问题。 通过DKT-DSC获得的显着收益可以在当前的知识追踪方面有所作为。 还将考虑对DKT-DSC在其他内容建议(电影和其他商业产品)中的潜在应用进行进一步调查。

VII 致谢

这项工作部分是在第一作者在日本国立信息学研究所实习期间完成的,并且还由授予第三作者的NSERC Discovery基金资