ENHANCING TRANSFORMATION-BASED DEFENSES AGAINST ADVERSARIAL ATTACKS WITH A DISTRIBUTION CLASSIFIER (ICLR 2020)

摘要

we propose a method to improve existing transformation-based defenses.

1 介绍

基于随机变换的防御方法在对抗攻击的防御中取得了相当大的成功。

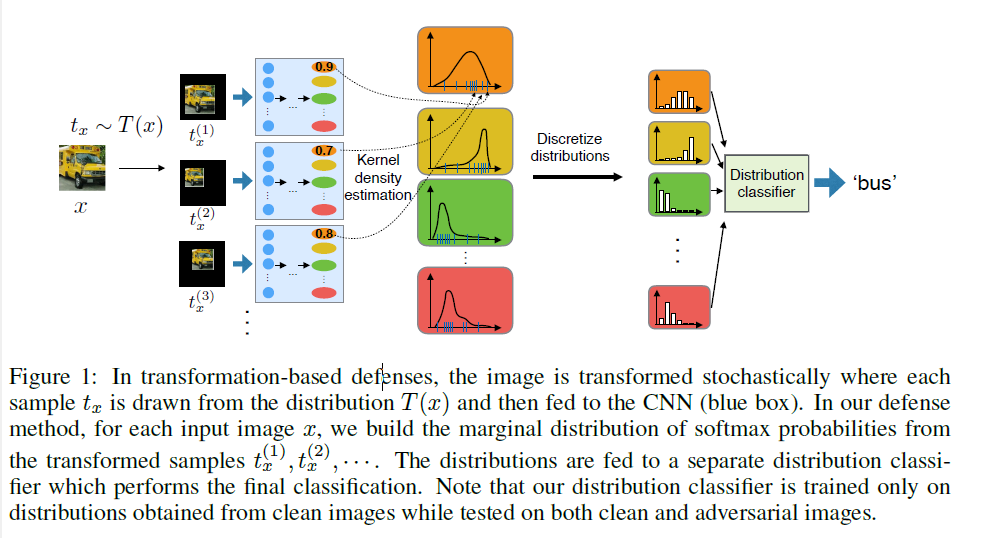

在这种防御中,输入图像在喂给CNN网络之前以某种方式进行变换,这样变换后的对抗样本将不再具有对抗性。因为变换是随机的,我们累积了一些列的CNN softmax 输出和预测。这样,基于变换的防御从随机变换的图像的中选择占大多数投票CNN的预测。

基于转换的防御是可取的,因为不需要重新训练CNN模型。但是,它们在干净图像上的性能会下降。

在干净图像性能下降的确切机制尚不清楚。我们认为,由随机变换产生的softmax分布包含了丰富的信息,而这些信息没有由简单计算变换样本的最终类预测的多数投票获得。

现在,一个有趣的问题是softmax分布中的特性是否可以得到更好的利用。

在图像变换后,一些干净图像显示了softmax的分布在不正确的类别,反映了之前观察到的投票精度下降。

虽然将分布移到不正确的类上不利于投票预测,但产生的softmax分布包含有用于校正预测的特征。

此外,我们观察到对抗的对方在softmax分布上的变化与干净图像相似。我们还研究了转换后的干净图像和对抗图像的分布形状,发现它们是相似的。

有了这些发现之后,我们提出了一个简单的方法来改善现在的基于变换的防御,我们训练了一个分离的轻权重的分布分类器来识别转换后的干净图像的softmax输出分布的显著特征,并预测类别标签。没有重新训练原始的CNN模型,我们的分布分类器提高了基于变换的防御在干净和对抗图像上的表现。

我们的防御方法是攻击无关的。我们的贡献如下:

1.我们分析了现有防御系统中图像变换对干净图像和对抗图像的softmax输出的影响,发现从干净图像和对抗图像中获得的softmax分布具有相似的特征。

2.我们提出了一种只根据变换后的干净图像的softmax输出分布训练分布分类器的方法,但是在干净图像和对抗图像中都显示了改进。该方法对攻击方法不可知,不需要对CNN进行再训练,可以与现有的基于变换的方法集成。