arxiv 2020

论文链接:https://arxiv.org/pdf/2005.01159.pdf

github链接:https://github.com/luyang-huang96/GraphAugmentedSum

看具体内容,直接跳转链接。本文只从个人角度出发看本篇paper。

疑惑

- 数据集:

NYT:training, validation, and test sets 588909, 32716, and 32703 samples

CNN/Daily:training, validation, and test sets 287188, 13367, and 11490 samples - graph如何构建?

利用了OpenIE

- graph如何应用?

两种形式:1)捕获文档级别的交互 ;2)段落内的交互和段落之间主题的转移。这两个合起来是graph encoder部分。

首次在ABS任务中利用了图神经网络的方式接入graph,之前。 - entity linking工具?

第三章指出:文章未用到EL,文章的方法是用CoreNLP先解决共指问题,然后用OpenIE获取triple,用triple直接构建document-level的图。

- 如何测评?

Rouge测评

- 具体模型设置?具体参考

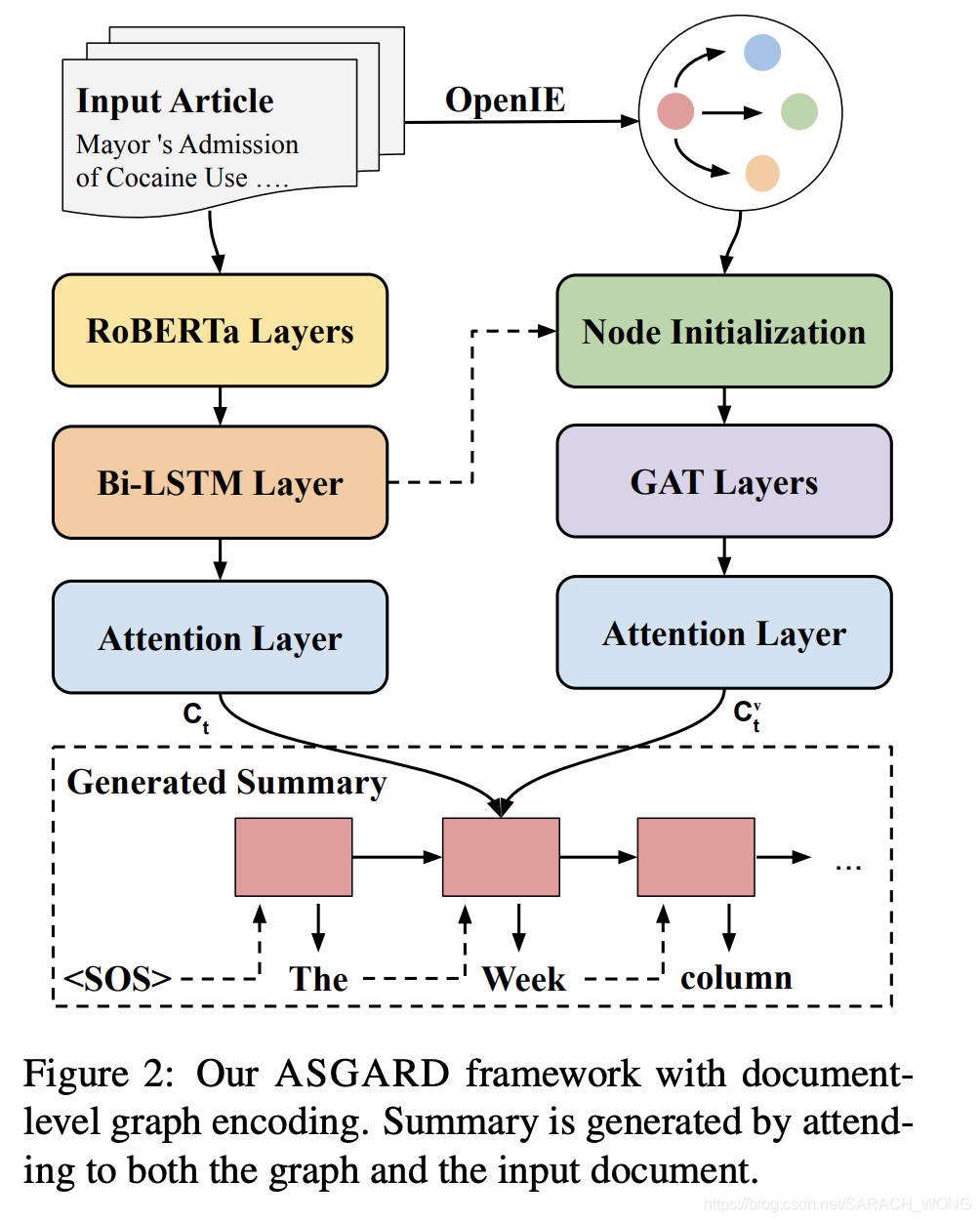

seq部分:RoBERTa 最后一层 + BiLSTM

graph 部分分了两种:捕获全局信息的DocGraph和捕获段落之内以之间的主题迁移的SegGraph

加入了copy机制 - 为什么非要添加entity?

能够捕获段落之间的交互和段落之间的主题转移。“graph-structured encoder to maintain global context and local characteristics of entities”

- 如果KG能在输出摘要中引入更加丰富的信息话,如何更合理的度量?

- 文章的出发点中缺乏semantic interpretation是什么意思?

- 输入/输出的长度是多少,输入短的话KG是否能用?

- 文章指出抽取式摘要会产生unfaithful content和nearextractive summaries问题(非常合理),如何解决的?

- 效果比较BERTSum (Liu and Lapata, 2019), UniLM (Dong et al., 2019), and BART (Lewis et al., 2019)更好。

- 实验结果说 "our models generate more informative summaries with less unfaithful errors than their counterparts without the graph encoder. " 是否有解释?

- 文章指出了rouge测评的问题,这是众所周知的,但是是否提出的更好的测评方案呢?

- training objective?

除了平常见到的极大似然函数 L s e q L_{seq} Lseq?还另外加了一个Node Salience Labeling L m a s k L_{mask} Lmask?,即最终的目标函数是:

L m l = L s e q + L m a s k L_{ml} =L_{seq} + L_{mask} Lml?=Lseq?+Lmask? - 文章提到"a novel multi-choice cloze reward to drive the model to acquire semantic understanding over the input"是什么意思?

完型填空的方式促进entity之间的交互,通过强化学习实现。

模型:

个人想法

直接从表格看效果都不如BART,且模型加入了reward机制后非常复杂,那么引用的意义?

可留意的参考文献:

- STRUCTURED NEURAL SUMMARIZATION

- 图结构在抽取式摘要中的应用:TextRank、Lexrank

- Tan et al. (2017) 利用图结构去确定重要的句子。

- Fernandes et al. (2019) 图结构

- Fan et al. (2019) 图结构,OpenIE

- Beck et al. (2018) 为了减少模型的参数,为predicates创建nodes?

- openIE使用