论文链接:https://arxiv.org/abs/1801.00908

论文简介

我们提出了一种通过传输封装在基于图像的实例嵌入网络中的知识来进行无监督视频对象分割的方法。实例嵌入网络为每个像素生成嵌入向量,以便识别属于同一对象的所有像素。虽然在静态图像上进行了训练,但实例嵌入在连续的视频帧上是稳定的,这使我们可以随时间将对象链接在一起。因此,我们将在静态图像上训练的实例网络适应视频对象分割,并将对象与光学流动特征相结合,而无需模型再训练或在线微调。

现状和不足

视频理解的一个重要任务是时间和空间中的对象定位。理想情况下,它应该能够使用尖锐的对象mask定位随时间推移的熟悉或新颖的对象,这被称为视频对象分割(VOS)。如果没有给出要分割的对象的指示,则该任务称为无监督视频对象分割或主要对象分割。

静态图像中的相关对象分割任务目前由基于FCN的方法主导[1]。这些神经网络需要具有图像对象标注的的大型数据集,如PASCAL [2]和COCO [3]。 视频分割数据集较小,因为它们更难以标注[4]。 因此,明确地训练神经网络用于视频分割相对来说更加困难。

论文方法

在论文中,提出了一种方法来转移在静态图像中学习的实例分割嵌入中封装的知识,并将其与对象得分和光流相结合,以对视频中的运动对象进行分割。我们认为适用于图像转移到视频情况时,实例嵌入是相对于使用前景/背景像素预测方法的更有用的特征。下图给出实际示例:

汽车是顶部视频中的前景,也是底部视频中的背景。为了解决这个问题,我们的方法获得了对象实例的嵌入,并识别了前景/背景的代表嵌入,然后根据代表嵌入对帧进行分段。 左:真相。 中间:通过PCA投影到RGB空间的嵌入的可视化,以及前景(品红色)和背景(蓝色)的代表点。 右:由所提出的方法产生的分割掩模。最后,通过在一组代表性前景或背景嵌入中找到最近邻居来对所有像素进行分类。这是一个非参数化过程,不需要视频特定的训练或测试监督。

论文贡献

(1)一种新的用于调整在静态图像上训练的实例分割模型用到视频上去的策略。

(2)该策略在DAVIS基准和FBMS基准测试中均优于先前发布的非监督方法,并且在测试时无需再训练任何网络即可接近半监CN的性能

(3)提出在没有监督对象的前提下选择前景的新标准,基于语义分数和轨道上的运动特征。

(4)深入了解实例分段嵌入随时间推移的稳定性。

采用无监督方法的好处

(1)尽管存在关注错误对象的风险,但可以在更多地方部署无监督方法,因为它们不需要用户交互来指定要分段的对象。由于我们对不需要用户互动的方法感兴趣,因此我们选择专注于无监督分割。

(2)半监督分割中微调可能需要几秒到几分钟,更长的微调通常会导致更好的分割。避免微调的时间成本进一步促使人们关注无监督方法。

论文细节

下图描述了所提出方法的概述:

我们首先获得将用作输入的实例嵌入,对象分数和光流,基于实例嵌入,我们识别标记分割提议的“种子”点,连续的提议种子与构建种子轨道相关联,我们按对象分数和运动显着性对种子轨道进行排序,以在每个帧上选择前景提议种子, 我们进一步构建了一组前景/背景提议种子,以在每个帧中生成最终的分割掩码。

下面介绍详细细节:

(1)抽取特征

我们的方法使用三个输入:实例嵌入,对象分数和光流。这些功能都不会在视频对象分割数据集上进行微调。每个帧对应的三个特征提取细节如下:

实例嵌入和对象得分:

我们训练网络在图像实例分割任务上输出实例嵌入和语义类别,如[5]中所述。 简而言之,实例嵌入网络是一个密集输出的卷积神经网络,其中两个输出头在实例分割数据集的静态图像上进行训练。

第一个头输出每个像素的嵌入,其中来自相同对象实例的像素在它们之间具有比属于单独对象的像素更小的欧式距离;第二个头输出来自语义分割的对象分数。 我们最小化语义分割log loss,以训练第二个头输出每个像素的语义类别概率。

嵌入图:

我们从密集嵌入映射构建一个4邻域图,其中每个嵌入向量都是一个顶点,并且在空间相邻嵌入之间存在边,其权重等于嵌入向量之间的欧几里德距离。 该嵌入图将用于稍后生成图像区域。可视化嵌入图如下图所示:

光流:

运动显着性线索建立在光流上。 为了以高精度进行快速光流估计,我们利用FlowNet 2.0 [6]的重新实现,它属于迭代神经网络。

(2)产生提议种子

对于视频中的帧K的一些子集(通常是全部),我们在帧k中提出少量代表性种子点Sk。 大多数计算仅与当前帧内的种子进行比较,因此为清楚起见省略了上标k,除非计算跨越多个帧。我们认为FG或BG的种子在嵌入空间中应该是多样的,因为分割目标可以是来自任意类别的移动对象。在一组不同的种子中,至少一个种子应该属于FG区域,至少一个BG种子,因为嵌入空间中的距离是相对的。

两个对象边界上的嵌入通常不接近任一对象的嵌入。 因为我们想要嵌入对象的代表,我们从对象边界中排除种子。为了避免对象边界,我们仅从实例嵌入在本地一致的候选点中选择种子。我们采用KMeans ++初始化[7]中的抽样程序,将这些候选种子的不同子集作为真正的种子。采样程序首先将具有最大对象得分的候选点添加到种子集中,通过迭代添加候选点进行连续采样,与所有先前选择的种子具有最小的最大相似性,即可选择,达到目标种子数时停止。

(3)排序提议的种子

在无监督的视频对象分割问题中,我们没有明确指定的目标对象。因此,我们需要将移动物体识别为分割目标(即FG)。我们首先根据对象性和运动显着性对种子进行评分。为了找到最有希望的FG种子,我们然后通过组嵌入一致种子来构建种子轨道,跨越帧到种子轨道和沿着轨道的聚合分数。下面解释运动显着性以及种子轨道构造和排名。

运动显着性:

光流的差异可以分离在背景中移动的物体[8]。由于光流估计仍然不完善,们在图像区域内平均流动而不是使用来自单个像素的流动。对于每个种子s,我们使用相应区域中的平均光流作为对比。图像区域的示例在下图给出:

种子轨道:

前景对象的另一个属性是它应该是多个框架中的显着对象。我们通过将相似的种子连接在一起来得分,进入种子轨道并取出物体的平均产物-每条赛道的得分和运动显着性得分。

(4)分割前景提议

分割前景提议包括五个步骤:初始化前景分割,添加前景种子,添加背景种子,最终细分和在线改编。

初始前景分割:

在每个帧上选择具有最高前景分数的种子轨道以提供初始前景种子。我们通过识别嵌入图中靠近前景种子的像素来获得初始前景分割。我们再次将具有最低物体得分的种子作为初始背景种子集,然后,初始前景区域由比任何背景种子更接近前景种子的像素组成。

添加前景种子:

通常,选择单个前景种子过于保守,初始分割不能覆盖整个物体。为了扩展前景分割,我们创建了一组前景种子。

添加背景种子:

背景包含两种类型的区域,即具有低对象得分的非对象区域(例如天空,道路,水等)和静态对象,静态对象在嵌入空间中,通常比非对象背景更接近前景。当静态对象属于与前景对象相同的语义类别时,就更加具有挑战性。于是我们通过将对象得分小于阈值的种子与运动显着性得分小于阈值的种子联合起来,以扩展对背景区域的表示。

最终细分:

一旦建立了前景和背景集合,就为每个像素计算与最近的前景和背景种子的相似度。可以使用一帧中的前景和背景集来分割另一帧以进行前景/背景相似度计算。最后,密集的CRF [9]用于细化分割掩模。

在线改编:

在线改编只需生成一组新的前景和背景种子。这比微调FCN以进行适应要经济得多,虽然更新前景和背景集可能会导致在不同的帧中分割不同的对象,但它通常会改善结果。

实验情况

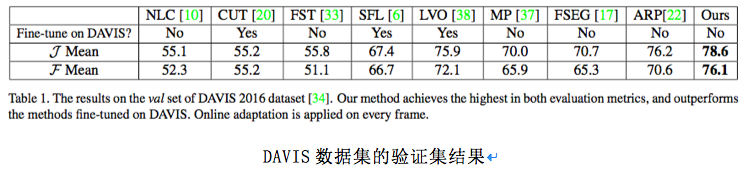

文章在DAVIS数据集[10],Freiburg-Berkeley运动分割(FBMS)数据集[11]和SegTrack-v2数据集[12]上评估了所提出的方法。我们使用在PASCAL VOC 2012数据集上训练的图像实例分割网络来提取对象嵌入和对象。实例分段网络基于DeepLab-v2,ResNet作为主干,并使用了来自FlowNet2.0重新实现的稳定光流。与最先进的技术相比,在DAVIS数据集上的效果如下表所示:

如上表所示,我们获得了无监督视频对象分割的最佳性能。我们的无监督方法甚至超出一些可以访问第一帧注释的半监督方法如VPN [13]和SegFlow [14]方法2%。一些定性分割结果如下图所示。

文章的方法在具有大的外观变化(顶行),容易混淆的背景(第二行,背景中的人)和改变视角(第三行)的视频上表现良好。

结论

在文章中,我们提出了一种方法,将从静态图像中学习的实例嵌入转换为视频中不受约束的对象分割。为了适应视频对象分割问题中不断变化的前景,我们训练网络生成封装实例信息的嵌入,而不是训练直接输出前景/背景分数的网络。 在实例嵌入中,我们从对象性和运动显着性中识别出代表性的前景/背景嵌入。 然后,基于与前景/背景的嵌入相似性对像素进行分类。 与之前需要对目标数据集进行微调的许多方法不同,我们的方法在无监督的视频对象分割设置下实现了最先进的性能,无需任何微调。

参考文献

[1] L.-C. Chen, G. Papandreou, I. Kokkinos, K. Murphy, and A. L. Yuille. Deeplab: Semantic image segmentation with deep convolutional nets, atrous convolution, and fully con- nected crfs. IEEE Transactions on Pattern Analysis and Ma- chine Intelligence, 2016.

[2] M. Everingham, L. Van Gool, C. K. Williams, J. Winn, and A. Zisserman. The PASCAL visual object classes (VOC) challenge. International Journal of Computer Vision (IJCV), 88(2):303–338, 2010.

[3] T.-Y. Lin, M. Maire, S. Belongie, J. Hays, P. Perona, D. Ra- manan, P. Dolla ?r, and C. L. Zitnick. Microsoft COCO: Com- mon objects in context. In European conference on computer vision, pages 740–755. Springer, 2014.

[4] F. Li, T. Kim, A. Humayun, D. Tsai, and J. M. Rehg. Video segmentation by tracking many figure-ground segments. In Proceedings of the IEEE International Conference on Com- puter Vision, pages 2192–2199, 2013.

[5] A. Fathi, Z. Wojna, V. Rathod, P. Wang, H. O. Song,

S. Guadarrama, and K. P. Murphy. Semantic instance segmentation via deep metric learning. arXiv preprint arXiv:1703.10277, 2017.

[6] E. Ilg, N. Mayer, T. Saikia, M. Keuper, A. Dosovitskiy, and T. Brox. Flownet 2.0: Evolution of optical flow estimation with deep networks. In IEEE Conference on Computer Vi- sion and Pattern Recognition (CVPR), volume 2, 2017.

[7] D. Arthur and S. Vassilvitskii. k-means++: The advantages of careful seeding. In Proceedings of the eighteenth annual ACM-SIAM symposium on Discrete algorithms, pages 1027– 1035. Society for Industrial and Applied Mathematics, 2007.

[8] T. Brox and J. Malik. Object segmentation by long term analysis of point trajectories. Computer Vision–ECCV 2010, pages 282–295, 2010.

[9] P. Kra ?henbu ?hl and V. Koltun. Efficient inference in fully connected crfs with gaussian edge potentials. In Advances in neural information processing systems, pages 109–117, 2011.

[10] F. Perazzi, J. Pont-Tuset, B. McWilliams, L. Van Gool, M. Gross, and A. Sorkine-Hornung. A benchmark dataset and evaluation methodology for video object segmentation. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016.

[11] P. Ochs, J. Malik, and T. Brox. Segmentation of moving objects by long term video analysis. IEEE transactions on pattern analysis and machine intelligence, 36(6):1187–1200, 2014.

[12] F. Li, T. Kim, A. Humayun, D. Tsai, and J. M. Rehg. Video segmentation by tracking many figure-ground segments. In Proceedings of the IEEE International Conference on Com- puter Vision, pages 2192–2199, 2013.

[13] V. Jampani, R. Gadde, and P. V. Gehler. Video propagation networks. In IEEE Conference on Computer Vision and Pat- tern Recognition, volume 2, 2017.

[14] J. Cheng, Y.-H. Tsai, S. Wang, and M.-H. Yang. Segflow: Joint learning for video object segmentation and optical flow. In The IEEE International Conference on Computer Vision (ICCV), 2017.