- 问题:大多数命名实体识别(NER)系统只处理平面实体,而忽略了内部嵌 套实体,这无法捕获底层文本中的细粒度语义信息。

- 方法:为了解决这个问题,我们提出了一种新的神经模型,通过动态叠加平面NER层来识别嵌套的实体。模型将LSTM层的输出合并到当前平面NER层中,为检测到的实体构建新的表示,并随后将它们提供给下一个平面NER层。模型动态地堆加平面NER层,直到没有提取任何外部实体。

flat NER: 基本的BiLSTM+CRF

- 模型:嵌套NER模型基于平面NER层的顺序堆加设计,以端到端的方式检测嵌套实体。如图2所示:模型利用单个双向LSTM层来表示词序列,并通过将一个CRF层放在LSTM层之上来预测平面实体。如果预测到实体,则引入一个新的平面NER层,并合并当前平面NER层检测到的每个实体的单词序列表示,组成该实体的表示,然后将其作为输入传递到新的平面NER层。否则,模型将终止堆加,从而完成实体检测。

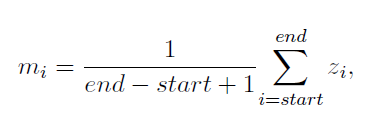

- Stacking flat NER layers:在当前平面NER层的顶部堆叠平面NER层,目的是为了提取外部实体。具体的来说是对检测到的实体中组成的区域的当前上下文表示进行加和平均。

- Zi : 表示来自平面NER层的第i个词表示

- Mi : 是实体的合并表示形式

Embedding layer:

Datasetes:

- GENIA: 包含36种实体种类(医学数据集), 我们把所有的DNA子类别都合并为DNA种类。同样的设置也适用于RNA、蛋白质、细胞系和细胞类类别。最终只保留5种类别。

- ACE2005: 包含7种实体种类(医学数据集)

- JNLPBA:我们在JNLPBA数据集进行了平面实体提取。

Experimental:

在GENIA上获得3.9%的提升,在ACE2005上获得9.1%的提升。

与GENIA相比,模型在ACE2005中F-score得到了更多的改进,有两种可能的原因。

- ACE2005包含深层的嵌套实体(最大嵌套层数为5),GENIA(最大嵌套层数为3)。这使得模型捕获嵌套实体之间潜在的“嵌套”关系。

- ACE2005有更多的嵌套实体(37.45%) ,GENIA (21.56%)。

在额外的实验中,将模型不同的两种输入进行了比较

- layered-BiLSTM-CRF w/o layered out-of-entities:使用当前平面NER层的输入来表示实体外单词。

- layered-BiLSTM-CRF w/o layered LSTM:跳过所有中间LSTM层,只使用嵌入层的输出做为下一个平面NER层的输入。

这表明,引入当前平面NER层的输入(例如跳过任何非实体或单词的表示或所有中间LSTM层)会损害性能。这是因为它们的表示没有包含当前的上下文。

- 表3和表4分别描述了GENIA和ACE2005测试数据集中每种实体类型的性能。

- GENIA:模型最好的性能是识别RNA种类,这是因为大多数与RNA相关的实体最终要么是“mRNA”,要么是RNA。其它种类与总体性能相当,原因是有许多实体可以对它们进行建模。

- ACE2005: PER,GPE也有更高的性能。FAC的少量实体是它们整体性能较差的原因之一。

个人总结:

该模型针对于特定数据集(具有多种类别和嵌套的实体),嵌套的实体越多层次越深,实验效果越好。