目录

- 入门篇:图像深度估计相关总结

- 应用篇:Learning to be a Depth Camera

- 尺度篇:Make3D

- 迁移篇:Depth Extraction from Video Using Non-parametric Sampling

- 深度篇:David Eigen

- 无监督篇:Left-Right Consistency & Ego Motion

- 相对深度篇:Depth in the Wild & Size to Depth

- SLAM辅助篇:MegaDepth

- 方法比较篇:Evaluation of CNN-based Methods

单目图像深度估计 - 无监督篇:Left-Right Consistency & Ego Motion

近几年有关单目图像深度识别的算法以CNN为主流,更细的说是以无监督的同时对深度、计算机角度、光流等同时计算的端到端深度网络为主流。

所谓无监督其实是指在训练过程中不需要输入真实的深度值,这样做有一个好处就是目前能够测量到深度信息的传感器还不够精确,因此由不够精确的label训练出的model得到的预测结果必然不会特别令人满意;

所谓同时计算呢,在我理解是指在训练过程中,用一个能够表征时间序列上有前后关系的帧之间的差别的loss同时训练多个网络,而在得到model后每个网络可以单独使用。

很聪明,不同作用的网络相当于人为的特征提取过程,最后的预测基于这个人为的特征提取结果,但这种方法也有其缺点,我能想到的就是参数的增加,网络结构的复杂化和人为特征对最终预测结果有没有起引导作用只能用实验去证明。

详细说呢,首先,所谓的“无监督”虽然不需要输入真实深度信息,但需要输入双目摄像头获取到的同一时刻不同角度的图像或者前后帧图像,只是这样就叫做无监督在我看来略显牵强。

其次,关于多网络共同训练,本来深度网络就很难解释,复杂化网络的结构得到多个看似可以解释的子网络,是否和深度网络的端到端黑盒特性有所冲突?较重的人为干涉是不是反而影响深度网络对数据隐含知识的理解和抽取?

以上只是我个人的一些思考,希望在未来的学习过程中能得到一些答案。

1. UnSupervised Learning of Depth and Ego-Motion from Video,CVPR,2017

接下来写一下Google发表于CVPR2017的这篇文章,从题目可以看出这篇文章提出了一种非监督的多功能网络,主要思想就像之前提到过的用一个loss同时训练两个网络。网络的结果如Fig.2,其中第一个网络可接受一幅图片作为输入,输出其对应的深度图片;第二个网络为姿态网络,接受t,t+1和t-1三个时刻三幅图片作为输入,输出从t到t+1和从t到t-1的相机姿态变化矩阵。

关于Pose的部分我不很了解,所以主要说明一下Depth CNN网络和Loss的结构。

Depth CNN

基本结构见上图,输入为前中后三帧连续的图片,同时训练两个网络,一个得到深度预测结果,一个得到视差矩阵结果。

其中视差网络用到了深度预测网络的预测结果。应用结构与DisNet相同的网络作为深度估计的网络,DispNet拥有主流的encoder-decoder结构,下一步打算看一下DispNet的相关Paper,因此在这不多介绍。作者提到使用多视角的图片训练深度预测网络结果和单张图片效果没有很大差异,说明光流约束需要在对多视角图片进行有效利用的前提下使用。

Loss

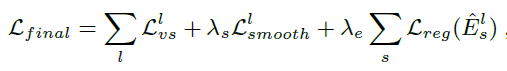

由Eq.4可见,Loss分为三个部分。其中第一部分为sample和target的差别,第二部分为多尺度平滑参数,第三部的目的是为了避免Es趋于0。

2. UnSupervised Monocular Depth Estimation with Left-Right Consistency, CVPR, 2017

这篇Paper主要思想为使用双目摄像头得到的同一时刻的两幅图片(left,right)进行训练,得到由left生成right(或right生成left)的网络,然后根据生成的双目图片得到depth。那所谓的无监督是指不需要ground truth depth,只需要双目图片。这种方法的好处是避免了深度测量硬件本身的误差,作者提出现有的深度测量硬件比如雷达、红外相机、TOF相机等本身就有误差,而且具有有效范围的限制,对比看来摄像头或双目摄像头硬件技术更为成熟,误差也会更小,因此在此基础上训练出来的网络应该有更好的精度。

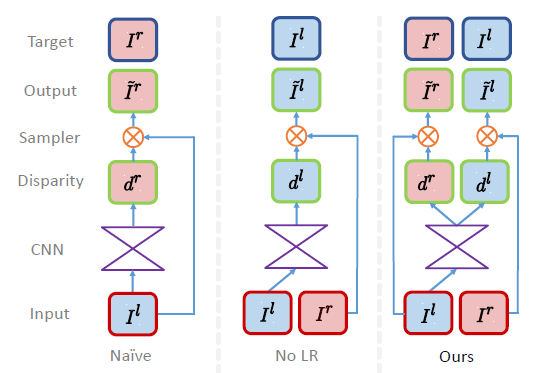

目前也有类似的由左图生成右图的方法,但本位方法的改进就在于提出了一种left-right consistency,在训练过程中不仅限制由左图到右图的连续性,同时也限制右图到左图的连续性。

上图为几种方法的比较,可以看出Naive方法的输出只受target影响,而NoLR方法的输出受左右图同时的影响,本文方法则在NoLR的基础上增加了左右连续性限制。

上图为文章的主要创新点:左右一致性Loss。这个Loss可以同时考虑到左右视差一致性、平滑性、重建效果。

Loss公式表示如上图,可见Loss分为三部分:

- 第一部分为与input的相似性

- 第二部分为平滑性约束

- 第三部分为左右一致性约束

CNN网络的结构夜视基于DispNet在此不再说明。

3. 总结

这两篇文章都是基于无监督的方法,但说是无监督又有点牵强,但我认为无论在那个研究领域,无监督都是最终的目标,毕竟label总有不可靠的概率,自我学习和纠正能力才是人工智能具有智能的真正标志。

两种方法都用到了DispNet,是不是可以说明现有的CNN模型结构完全可以胜任大部分计算机视觉任务呢?

很多CV相关的Paper中的网络结构总结起来有以下几种情况:

- 使用已有网络训练好的参数初始化

- 使用已有网络的结构

- 使用已有网络中的一部分

其中已有网络指VGG,ResNet,DispNet,LeNet等等。