文章目录

- 前言

- 知识复用

- 问题定义

- 知识复用策略

-

- 来自之前任务的知识

- 从示范学习 Learning from Demonstration

- 模仿学习 Imitation Learning

- 建议 Advising

- 课程学习 Curriculum Learning

- 其他相关领域 Additional Related Areas

- 开放问题和部分解决方法

前言

这是一篇提问题的文章,可以找找研究方向。在许多情况下,知识复用是保持训练次数合理的一个核心技术,为了这样,agent必须持续自动地复用来自许多源头的知识,包括自己之前内部的知识和其他agents的。本文对多智能体强化学习的知识复用方法进行了文献综述,给AI社区定义了一个重要的挑战性问题,调查了现有的方法,讨论他们如何有助于这个挑战性问题。更进一步的,我们标注了当前文献的空白,给那些对这个领域感兴趣的人一个容易实现的目标。

多智能体知识复用算法的一个主要问题可以被公式化为:

创建一个agent,可以自动识别和与其他agents建立允许显性或隐性的知识共享的关系,并且将接收到的信息与以往的经验结合起来,提高学习水平。

本文的贡献有:

- 介绍和推动普遍的知识复用挑战。

- 调查当前AI的许多子社区的文献怎么帮助解决这个挑战的

- 识别哪些领域还需要额外的研究

知识复用

花体H是算法可选择的策略集合,花体K是agent推断出一个策略有的所有可获得知识。花体A是算法。当从片段中学习时,花体K仅包含交互的样本。但是有别的源头就不一样了,上标source是来自之前任务的知识,上标agents是来自系统中其他agents 的知识,上标target是从探索新任务获得的知识。

然而决定when和what保存进知识库,和how使用它们来加速学习是一个长期研究的问题,还没有一个对所有领域有效的答案。

问题定义

下图是MAS中知识复用的一般情况:

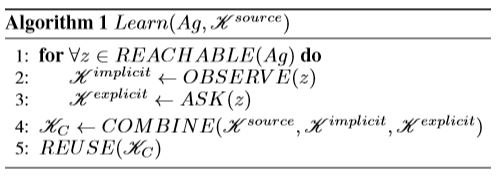

下图是agent学习的算法:

Ag是MAS中的agent集合。隐式地获取知识是观察别的agent怎么行动,显式的是与agent沟通,获得有用的知识,比如建议。同时利用以前的经验和其他agents的知识并不是一项简单的任务,因为生成的数据通常是多种多样的,并且不容易处理不同来源知识之间可能存在的冲突。大多数文献都只关注一个来源的知识。

知识复用策略

来自之前任务的知识

在任务间迁移知识的方法没有哪个能在所有领域超过其他方法,自动选择表现最好的方法是一个困难的开放问题。在对抗任务学习时,对抗一个对手的知识或许适用于别的对手,但这样就得评估对手间的相似性。

从示范学习 Learning from Demonstration

一个老师可以给缺乏经验的agent提供示范。示范是跟随老师策略的一系列与环境的交互的集合。学生可以通过建立一个对导师策略的预测性模型吸收这个集合,或者估计奖励或转移模型来加速学习。那些启导的关系通常仅固定在学习的开始,但理想情况下他们应该在战略时刻开始,比如学生在当前状态对于做什么相当不确定,这样可以避免在学生有良好策略的情况下浪费老师的注意。一个灵活的策略还应该考虑老师可能是次优的,使学生探索。

模仿学习 Imitation Learning

当agents之间没有直接的交流,要么因为没有可获得的共同消息传递协议,要么因为一个agent不愿意与别的agents共享他的知识。但可以通过观察行动学习行为。如果可以观察,一个有经验的agent可以隐式地交流关于他可能被观察者使用的策略的信息,即使观察者不能准确识别执行的是哪个动作。有经验的agent或许带着教导其他缺乏经验agent的意图行动,或者或许不知道或不关心其他agent正在观察。很难识别什么时候值得尽力模仿一个agent,因为观察者不知道是否其他的agent有同样的奖励函数,或是否在不模仿的情况下他的策略已经足够好了。

建议 Advising

动作建议是最灵活的知识复用之一,因为agents只需要对行动和当前状态有一个共同的理解。尽管大多数工作仅集中在要么如何从人类建议中获利最多,要么从人工agent间的建议。一个综合的建议框架将对agents一视同仁,不管他们的实现,只要提供建议时遵循某种协议。因为沟通通常有限或者耗费多,准确识别什么时候提供建议是关键的。虽然有些工作将开始建议关系的负担留给老师或学生,理想情况下,只有当两个agents都同意这对当前情况很重要时,才能提供建议。

课程学习 Curriculum Learning

课程学习将困难任务(target task)分解为简单一点的(source task),在一个方便的序列中学习。合适的训练应该能使用来自source task的知识,用来:

- 加速target task的学习,使得使用课程比不使用学的更快。

- 加速任务序列的学习,使得学习整个课程比直接学习target task更快。

然而定义合适的序列很困难。该子领域目前的一个挑战是设计能够为其他agents构建课程的agent,理想情况下,应考虑到学习agent的个人能力来构建课程。

其他相关领域 Additional Related Areas

开放问题和部分解决方法

现在列出一系列有前途的工作:

-

检测知识复用机会:agent需要识别是否知识源能提高自己的表现,联系或观察其他agent来建立一个合适的知识复用关系。尽管现存的一些工作旨在在agent对自己的策略不确定时激活知识复用技术,大多数的文献假设可用的知识是有用的,由专家提供。

-

任务相似性估计:agent需要找到之前解决的最相关的任务,避免negative transfer。只选择合适的知识非常重要,因为不一致的知识可能很难被重写。目前的方法通常应用有限,或者很难与多种知识复用技术结合。

-

知识源的一致结合:如果一个agent决定重用之前任务的策略,同时其他agent愿意提供示范和建议,那这个agent该怎么办?该怎么结合和吸收这个信息?通过这种不同数据结合来学习是一个新奇的研究问题。

-

信誉与知识质量检测:识别正确的时间和正确的接收知识伙伴对于自利MAS或许是不够的。因为文献均假设知识复用的交互是慈善的,从不会故意交流次优解,经常甚至不考虑老师的知识是不完美的,简单地认为交流的知识是最优的。agent或许需要协商知识negotiate knowledge,实现一个信任机制,避免收到恶毒交流的糟糕灾难。

-

表现度量:没有一个统一的标准,MAS知识复用方法表现评价经常是主观的,方法的比较也变得困难。

-

知识复用的理论分析:RL的知识复用方法主要是经验的。开发在regret和资源使用上有可知边界的理论方法对于这个领域将是一个巨大发展。

-

面向团队的沟通:大多数文献都集中在交流任务中局部状态仅受自己动作影响的知识,但是当需要协作时,交流的知识就要根据接收方扮演的角色来调整,而不是遵循传递方的策略。然而如何自动调整内在知识来鼓励协作仍然是个未解决的问题。

-

知识交换协议:需要明确的协议,使得新的agent能快速简单加入,参与和理解交流。