目录

1.摘要

2.前言

3.说话人识别系统SPEAKER RECOGNITION SYSTEMS

3.1Acoustic i-vector

3.2Phonetic bottleneck i-vector

3.3x-vector

4.数据增广Data augmentation

关键字:说话人识别,深度神经网络,数据增强,X-vectors

1.摘要

使用数据增强来提高深度神经网络(DNN)嵌入的说话人识别的性能。DNN被训练用来区分说话者,它将可变长度的话语映射到固定维的嵌入中,我们称之为x-vectors。使用数据增强,包括增加噪声和混响,提高鲁棒性。

2.前言

本文之前常用的模型叫做i-vectors,该文提出的模型叫做x-vectors。在训练特征的提取时采用了数据增强的方式,有效提高了DNN的性能。

i-vectors由UBM模型、映射矩阵T和分类器组成,UBM是一个通用的声学特征提取器,提取的特征向量features,送入映射矩阵T,得到维度低一些的i-vectors,由分类器判别i-vectors是否来自不同说话人。

神经网络可以直接被优化为说话人识别器,且仅仅需要说话人的标签。

3.说话人识别系统SPEAKER RECOGNITION SYSTEMS

3.1Acoustic i-vector

基于GMM-UBM架构,特征是20个mfcc,帧长为25ms,在3秒的滑动窗口上进行规范化。特征向量是附加了增量和加速创建的60维向量。基于能量的语音活动检测(SAD)用来选择与语音帧相对应的特征。UBM是一个2048分量的全协方差GMM。该系统使用一个600维的i-vector提取器和评分用的PLDA。

3.2Phonetic bottleneck i-vector

这个i-vector包含了来自ASR DNN声学模型的语音瓶颈特征(BNF)。DNN是一种具有p范数非线性的时滞声学模型。ASR DNN倒数第二层被60维的线性瓶颈层取代。BNF与第3.1节中描述的mfcc和增量连接起来,成100维的特征。该系统的其余组成部分(特征处理、UBM、i-vector提取器和PLDA分类器)与第3.1节中的声学vector相同。

3.3x-vector

这些特征是24维的滤波器组,帧长为25ms,在一个高达3秒的滑动窗口上进行平均归一化。与在基线系统中使用的相同的SAD算法过滤掉非语音帧(空白帧)。

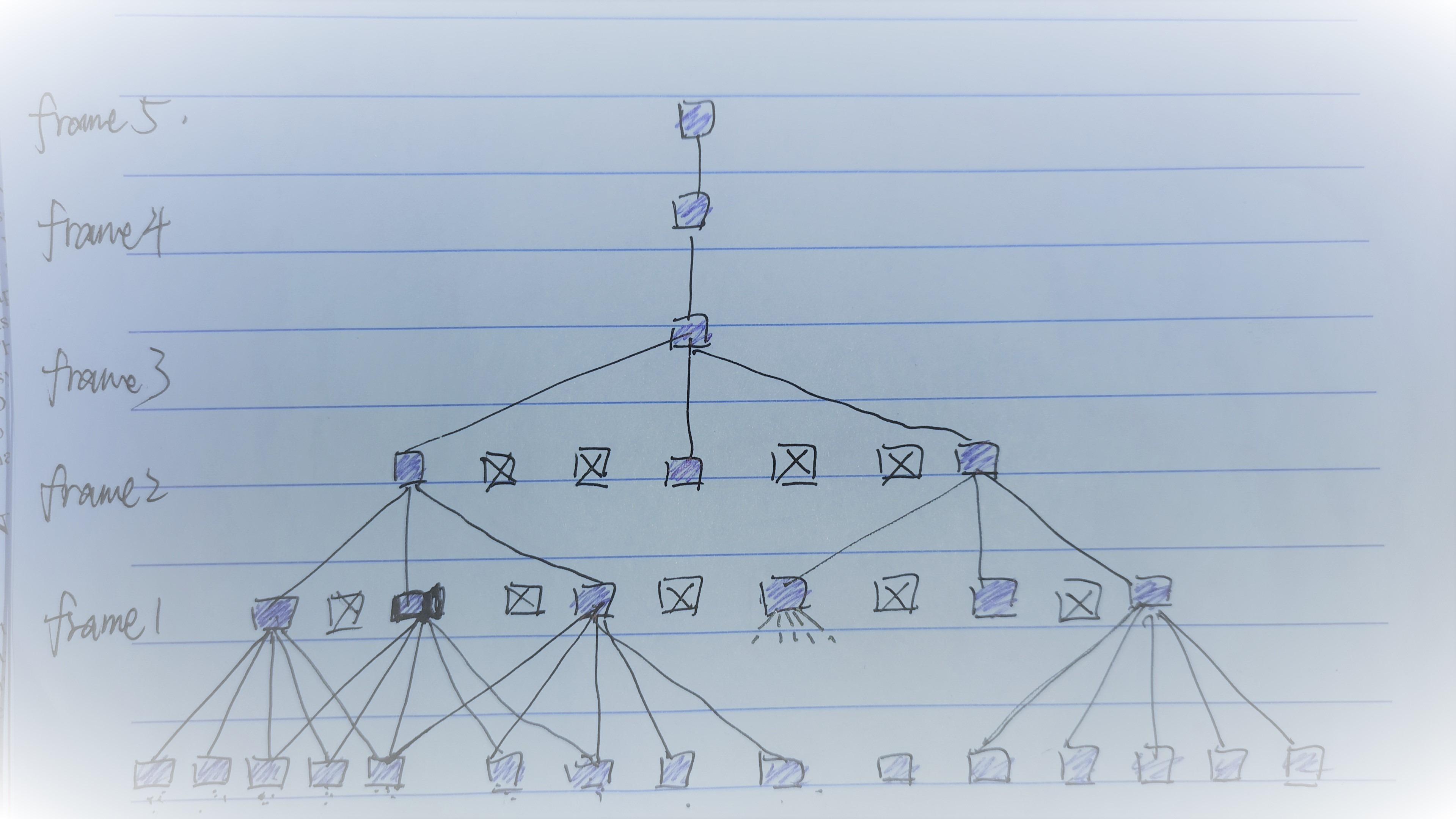

如图所示,一段语音分为T段,每段有15帧。前五层是帧级网络,网络的连接图如下(手绘图来自声纹识别X-Vector - 草祭 (yyqx.online)):

第一层的每一个输出由[t-2, t+2]区间 范围的5个帧拼接得出,第二层的输出由{t-2,t,t+2}集合内的3个帧拼接,但总的来说,往前推的话其实是由第一层前输入的9个帧计算得来的,第三层、第四层以此类推,最终的输出融合了15个帧的信息。

每个段的15帧经过statistics polling统计池化层,即T个1500维的向量,在每个维度上计算均值和方差,得到1500维的均值向量加1500维的方差向量,共计3000维的向量,该向量融合了所有段的信息。

最后经过softmax层输出说话人概率。

4.数据增广Data augmentation

增强增加了现有训练数据的数量和多样性。我们的策略是附加噪声和混响。混响包括将房间脉冲响应(RIR)与音频进行卷积。对于附加噪声,我们使用MUSAN数据集,它包含超过900个噪音,来自不同类型的42小时的音乐和来自12种语言的60小时的语音。

为了增加录音,我们在以下随机选择之一:

- 说话声:从MUSAN语音中随机抽取3到7个说话者,累加起来,然后添加到原始信号中(13-20dB信噪比)。

- 音乐:从MUSAN中随机选择一个单一的音乐文件,根据需要进行裁剪或重复,并添加到原始信号中(5-15dB信噪比)。

- 噪声:在整个音频中每秒钟添加MUSAN噪声(0-15dB信噪比)。

- 混响:与模拟RIRs的卷积进行人工混响。