课程简介 :

这是该课程的最后一课,作者首先总结了有关机器学习的理论、方法、模型、范式等。最后介绍了贝叶斯理论和Aggregation(聚合)方法在机器学习中的应用。

课程提纲 :

1、机器学习的地图。2、贝叶斯理论。

3、Aggregation(聚合)。

1、机器学习的地图

有关机器学习的方法、模型等非常多,简直令人目不暇接。比如下图列出来的。然而不建议一一学习这些方法、模型,否则容易迷失在这些方法里无法自拔。如果我们对于机器学习的框架认识的足够深刻,那么我们才能驾驭众多的方法。

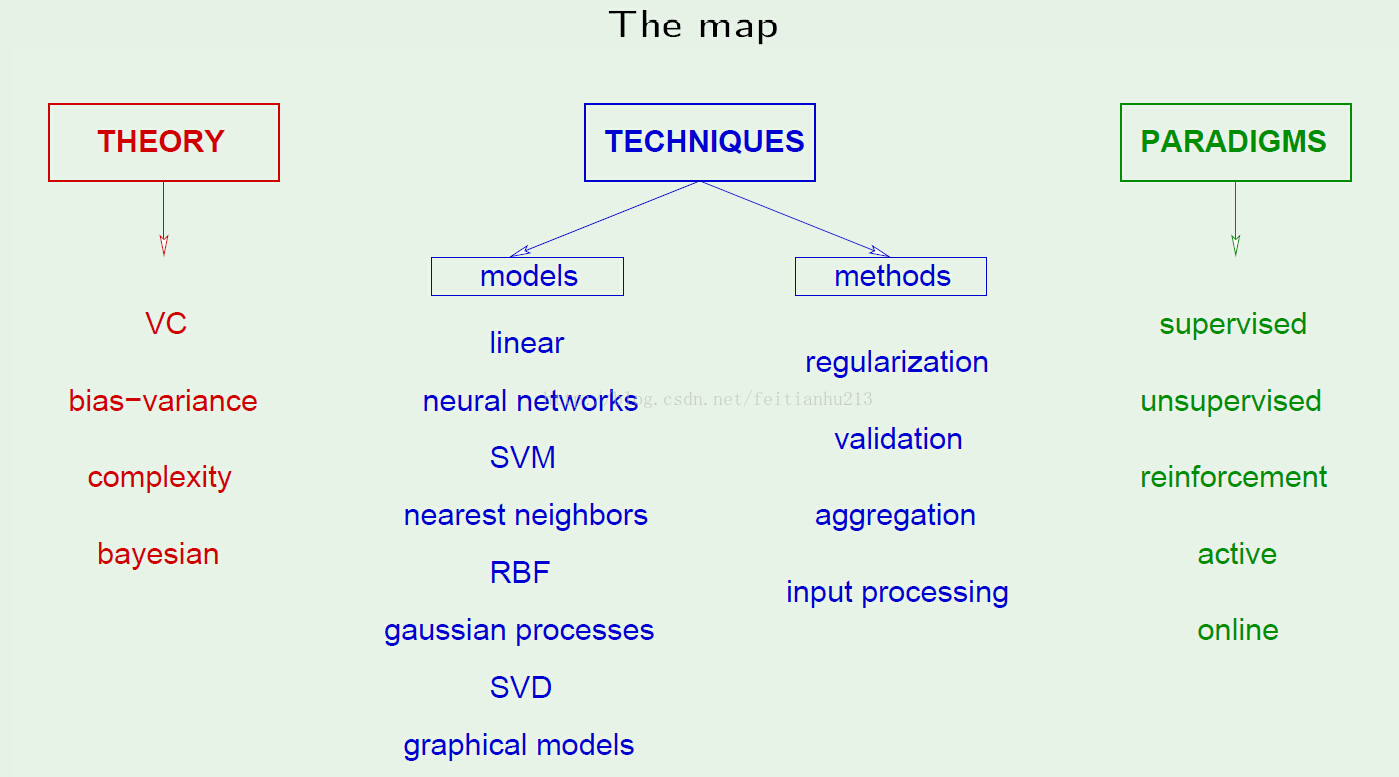

下面列举了机器学习的基本框架,需深刻理解。

理论作为机器学习的根基,乃万物之源。没有理论的支撑,一切都只是耍流氓。范式则是为我们的问题提供了一个大的方向,不同的问题对应不同的范式。当我们知道当前正在解决的问题所属范式的时候,便更容易找到解决的方法。因为在范式下已经有了初步的指导方针。技术则是我们解决某个问题的具体方法。

2、贝叶斯理论

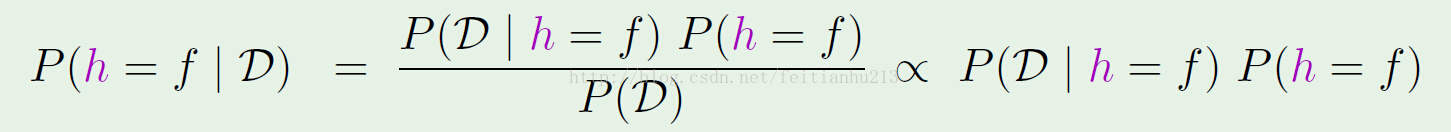

根据贝叶斯理论有:

其中 h 是假设,D 是数据集,f 是目标函数。P(h=f) 为先验概率,P(D|h=f) 为只要我们知道了 P(h=f) 及 P(D|h=f)。那么我们就可以知道在给定数据集的情况下,哪个假设(h)能够更好的近似 f 了。问题是:如何知道P(h=f) 及 P(D|h=f) ?

其中 h 是假设,D 是数据集,f 是目标函数。P(h=f) 为先验概率,P(D|h=f) 为只要我们知道了 P(h=f) 及 P(D|h=f)。那么我们就可以知道在给定数据集的情况下,哪个假设(h)能够更好的近似 f 了。问题是:如何知道P(h=f) 及 P(D|h=f) ?一般情况下我们没办法直接计算 P(h=f),只能通过经验估计出 P(h=f) 的值(-_-)。而 P(D|h=f) 的计算则要考虑噪声的影响了。总而言之:难求。【看视频几次都看不到怎样求...】,可以参考这里。

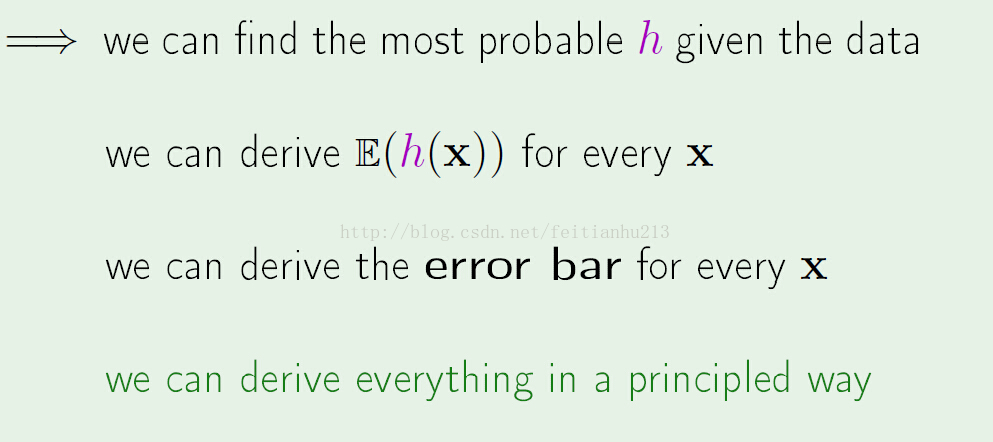

如果我们知道了先验概率,我们就可以:

贝叶斯理论非常有用,非三言两语可以说清,还得看专门介绍的书才行。

3、Aggregation(聚合)

什么是聚合?就是进行多个独立的学习过程,最后对结果进行组合输出。注意的是,这里的个个学习过程都是互相独立的。有两种类型的聚合:

1)After the fact:组合已经存在的解决方案。

2)Before the fact:生成将被组合的解决方案。

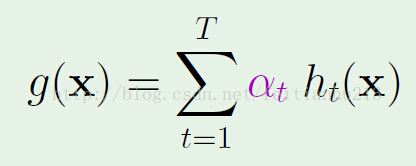

对于第一种方案,对于回归方程来说,假设现在有假设集:h1,h2,。。。ht,则:

权重 a 的选择原则是:最小化聚合假设集中的误差。

对于第二种方案,有:bagging、boost 等方法。