Attentional Encoder Network for Targeted Sentiment Classification(2019)

面向的问题: 以前的大多数方法都是用RNN和注意力来模拟语境和目标词。然而,RNN很难并行化,并且随时间截断的反向传播给记忆长期模式带来了困难。

创新:

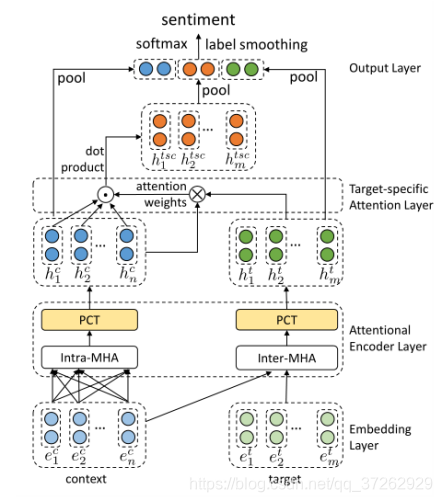

1.本文提出了一种避免重复出现的注意编码网络(AEN),并采用基于注意的编码器对上下文和目标进行建模。

2.提出了新的bert预训练模型BERT-SPC。序列标注如下:“[CLS] + context + [SEP] + target + [SEP]”

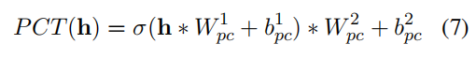

点卷积变换(PCT):

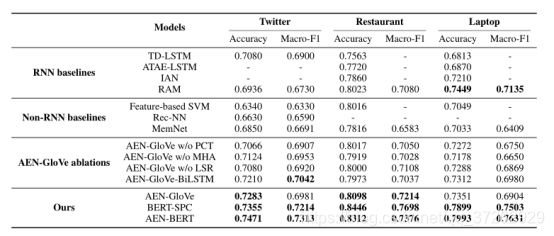

实验结果:

总结: 面向目标的注意力嵌入网络,就是单独对aspect、sentence进行处理,嵌入方式可以使用预训练的bert或者是glove。感觉并没有什么新东西。