版权声明:来源请注明出处 https://blog.csdn.net/qq_40196164/article/details/85834382

PointNet:用于3D分类和分割的点集的深度学习

摘要:点云是几何数据结构的重要类型。 由于其格式不规则,大多数研究人员将这些数据转换为规则的三维体素网格或图像集合。 但是,这会导致数据不必要的庞大并导致问题。 在本文中,我们设计了一种直接消耗点云的新型神经网络,它很好地尊重了输入点中的点的置换不变性。 我们的网络,名为PointNet,提供了从对象分类,零件分割到场景语义分析等应用的统一架构。 虽然简单,但PointNet非常高效和高效。 从经验上讲,它表现出强劲的表现,甚至比现有技术更好。 理论上,我们提供分析以了解网络已经学到了什么,以及为什么网络在输入扰动方面是强健的。

1.介绍

在本文中,我们探讨了能够推理三维几何数据(如点云或网格)的深度学习架构。 典型的卷积架构需要高度规则的输入数据格式,如图像网格或3D体素,以便执行权重共享和其他内核优化。 由于点云或网格不是常规格式,因此大多数研究人员通常会在将这些数据馈送到深层网络体系结构之前将这些数据转换为常规3D体素网格或图像集合(例如视图)。 然而,这种数据表示转换会导致产生的数据不必要的庞大,同时也会引入量化伪像,这些伪像会遮掩数据的自然不变性。

出于这个原因,我们专注于使用简单点云的三维几何体的不同输入表示法 - 并将我们生成的深层网络命名为PointNets。 点云是简单而统一的结构,避免了网格的组合不规则性和复杂性,因此更易于学习。 然而,PointNet仍然必须尊重点云仅仅是一组点,因此对其成员的置换不变,因此在净计算中需要一定的对称性。 还需要考虑进一步的僵化运动的不变性。

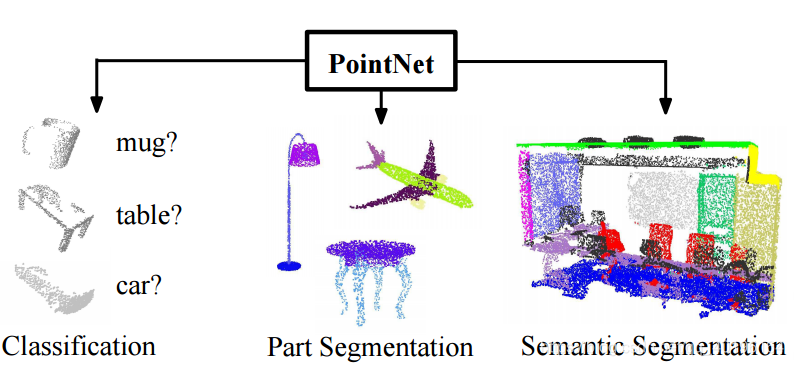

图1. PointNet的应用 我们提出了一种新颖的深层网络体系结构,它消耗原始点云(点集)而不需要体素化或渲染。 这是一个统一的架构,可以学习全局和局部点特征,为大量3D识别任务提供简单,高效和有效的方法。

我们的PointNet是一个统一的体系结构,它直接将点云作为输入,并为输入的每个点输出整个输入的每个分类标签或每个点分段/每个零件标签。 我们网络的基本架构非常简单,因为在初始阶段,每个点都被相同和独立地处理。 在基本设置中,每个点仅由其三个坐标 表示。 可以通过计算法线和其他本地或全局特征来添加其他维度。

表示。 可以通过计算法线和其他本地或全局特征来添加其他维度。

我们的方法的关键是使用一个单一的对称函数,最大池。 有效地,网络学习一组优化函数/标准,选择点云的有趣点或信息点并对其选择原因进行编码。 网络的最终完全连接层将这些学习到的最优值汇总为上述整体形状(形状分类)的全局描述符或用于预测每个点标签(形状分割)。

我们的输入格式很容易应用刚性或仿射变换,因为每个点都独立变换。 因此,我们可以添加一个依赖数据的空间转换网络,在PointNet处理它们之前尝试对数据进行规范化处理,以便进一步改进结果。

我们既提供了理论分析,也提供了对我们方法的实验评估。 我们显示我们的网络可以近似任何连续的点集功能。 更有意思的是,事实证明,我们的网络学习通过一组稀疏的关键点来总结输入点云,这些关键点根据可视化大致对应于对象的骨架。 理论分析提供了一个理解,为什么我们的PointNet对输入点的小扰动以及通过点插入(异常值)或删除(缺失数据)的腐败非常稳健。

在从形状分类,零件分割到场景分割等许多基准数据集上,我们通过实验将我们的PointNet与基于多视图和体积表示的现有技术方法进行比较。 在一个统一的体系结构下,我们的PointNet不仅速度更快,而且性能强劲,甚至比现有技术更好。

? 我们设计了一种适合在3D中消耗无序点集的新型深层网络体系结构;

? 我们展示如何训练这样的网络来执行3D形状分类,形状部分分割和场景语义分析任务;

? 我们对我们的方法的稳定性和效率提供全面的经验和理论分析;

? 我们举例说明由网络中所选神经元计算出的3D特征,并为其性能提供直观的解释。

神经网络处理无序集合的问题是一个非常普遍的基本问题 - 我们期望我们的想法也可以转移到其他领域。

2.相关工作

点云特征 点云的大多数现有功能都是针对特定任务手工完成的。 点特征通常对点的某些统计特性进行编码,并且被设计为对于某些转换不变,这些转换通常分类为内在[2,23,3]或外部[18,17,13,10,5]。 它们也可以分类为本地功能和全局功能。 对于特定的任务,找到最佳特征组合并不是微不足道的。

深度学习上的3D数据 3D数据具有多种流行的表现形式,从而导致各种学习方法。体积CNN:[25,15,16]是在体素化形状上应用3D卷积神经网络的先驱。然而,由于3D卷积的数据稀疏性和计算成本,体积表示受到其分辨率的限制。 FPNN [12]和Vote3D [23]提出了处理稀疏性问题的特殊方法;然而,他们的操作仍然是稀疏的卷,他们处理非常大的点云是一个挑战。 Multiview CNN:[20,16]尝试将3D点云或形状渲染为2D图像,然后应用2D转换网将其分类。通过精心设计的图像CNN,这种方法在形状分类和检索任务上取得了主导性能[19]。然而,将它们扩展到场景理解或其他3D任务(如点分类和形状完成)是不平凡的。频谱CNN:一些最新的作品[4,14]在网格上使用频谱CNN。然而,这些方法目前受限于诸如有机物等多种网格,并且如何将它们扩展到非等距形状(如家具)并不明显。基于特征的DNN:[6,8]首先通过提取传统形状特征将三维数据转换为矢量,然后使用完全连通的网络对形状进行分类。我们认为他们受到提取特征表示能力的限制。

深度学习在无序集 从数据结构的角度来看,点云是一组无序的向量。 虽然大多数深入学习的作品集中在像序列(语音和语言处理),图像和音量(视频或3D数据)等常规输入表示方面,但在深度学习点集中没有做太多工作。

Oriol Vinyals等人最近的一项研究[22]研究了这个问题。 他们使用带有注意机制的读进程写网络来消费无序输入集,并显示他们的网络能够对数字进行排序。 然而,由于他们的工作主要集中在通用集合和NLP应用程序上,因此缺乏几何在集合中的作用。

3.问题陈述

我们设计了一个深度学习框架,直接消耗无序点集作为输入。 点云被表示为一组3D点 ,其中每个点

,其中每个点 是其

是其 坐标加上额外的特征通道如颜色,法线等的向量。为了简单和清楚,除非另有说明,否则我们仅仅 使用

坐标加上额外的特征通道如颜色,法线等的向量。为了简单和清楚,除非另有说明,否则我们仅仅 使用 坐标作为我们点的通道。

坐标作为我们点的通道。

对于对象分类任务,输入点云或者从形状直接采样,或者从场景点云中预先分割。 我们提出的深度网络为所有 个候选类别输出

个候选类别输出 个分数。 对于语义分割,输入可以是用于部分区域分割的单个对象,或者来自用于对象区域分割的3D场景的子体积。 我们的模型将为

个分数。 对于语义分割,输入可以是用于部分区域分割的单个对象,或者来自用于对象区域分割的3D场景的子体积。 我们的模型将为 个点和

个点和 个语义子类别中的每一个输出

个语义子类别中的每一个输出 分数。

分数。

4.点集上的深度学习

我们网络的体系结构(Sec 4.2)的灵感来自 (Sec 4.1)中的点集属性。

(Sec 4.1)中的点集属性。

4.1  中点集的性质

中点集的性质

我们的输入是来自欧几里得空间的点的子集。 它有三个主要属性:

? 无序。 与图像中的像素阵列或体积网格中的体素阵列不同,点云是一组没有特定顺序的点。 换句话说,消耗N个 3D点集合的网络需要不变为 ! 按数据馈送顺序设置输入的排列。

! 按数据馈送顺序设置输入的排列。

? 点之间的互动。 点来自具有距离度量的空间。 这意味着点不是孤立的,并且相邻点形成一个有意义的子集。 因此 该模型需要能够捕获附近点的局部结构以及局部结构之间的组合相互作用。

? 变换下的不变性。作为几何对象,点集的学习表示对某些变换应该是不变的。 例如,旋转和平移点不应该修改全局 点云类别或点的分割。

4.2 Pointnet 结构

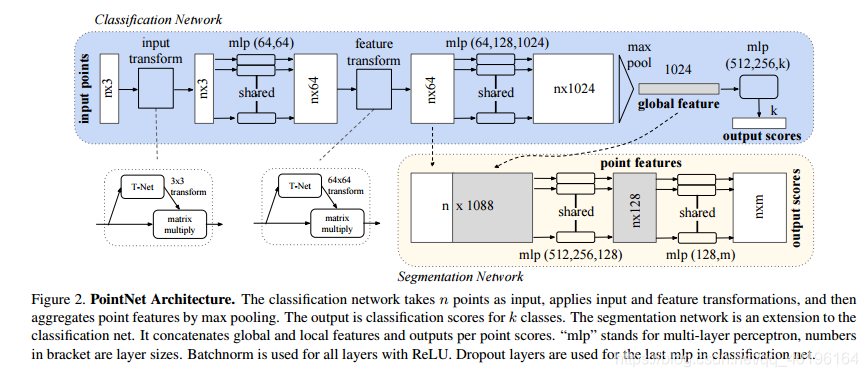

我们的完整网络体系结构在图2中可见,其中分类网络和分割网络共享大部分结构。 请阅读图2的管道标题.

图2. PointNet架构。 分类网络将n个点作为输入,应用输入和特征变换,然后通过最大池来聚合点要素。 输出是k类的分类分数。 分段网络是分类网络的扩展。 它将每个点的全局和局部特征和输出连接在一起。 “mlp”代表多层感知器,括号中的数字是层大小。 Batchnorm用于ReLU的所有层。Dropout图层用于分类网中的最后一个mlp。

我们的网络有三个关键模块:最大池层作为对称函数来聚合来自所有点的信息,本地和全局信息组合结构以及两个对齐输入点和点要素的联合对齐网络.

我们将在下面单独的段落中讨论我们设计选择背后的原因.

无序输入的对称函数 为了使模型对输入置换不变,存在三种策略: 1) 将输入分类为规范的顺序; 2) 将输入视为训练RNN的序列,但通过各种排列来增加训练数据; 3) 使用简单的对称函数来聚合每个点的信息。 这里,一个对称函数将 个向量作为输入,并输出一个对输入顺序不变的新向量。 例如,+ 和

个向量作为输入,并输出一个对输入顺序不变的新向量。 例如,+ 和  运算符是对称二元函数。

运算符是对称二元函数。

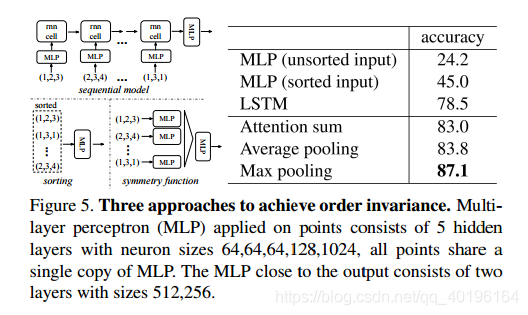

虽然排序听起来像一个简单的解决方案,但在高维空间中实际上并不存在一个稳定的排序  . 一般意义上的点扰动。 这可以通过矛盾很容易地显示出来。 如果存在这样的排序策略,则它定义高维空间和一维实线之间的双射图。 不难看出,要求序列稳定,点扰动相当于要求该映射在维数减少时保持空间接近度,这是一般情况下无法实现的任务。 因此,排序并不能完全解决排序问题,并且由于排序问题依然存在,网络难以学习从输入到输出的一致映射。 如实验所示(图5),我们发现直接在排序点集合上应用MLP的效果不佳,虽然稍好于直接处理未排序的输入.

. 一般意义上的点扰动。 这可以通过矛盾很容易地显示出来。 如果存在这样的排序策略,则它定义高维空间和一维实线之间的双射图。 不难看出,要求序列稳定,点扰动相当于要求该映射在维数减少时保持空间接近度,这是一般情况下无法实现的任务。 因此,排序并不能完全解决排序问题,并且由于排序问题依然存在,网络难以学习从输入到输出的一致映射。 如实验所示(图5),我们发现直接在排序点集合上应用MLP的效果不佳,虽然稍好于直接处理未排序的输入.

使用RNN的想法将点集视为顺序信号,并希望通过用随机置换序列训练RNN 654,RNN将变得对输入顺序不变。 然而,在“OrderMatters”[22]中,作者已经证明顺序确实很重要,不能完全省略。 虽然RNN对于具有小长度(数十个)的序列的输入排序具有相对良好的鲁棒性,但是难以扩展到数千个输入元素,这是点集的常见大小。 根据经验,我们还表明基于RNN的模型的表现不如我们提出的方法(图5)。

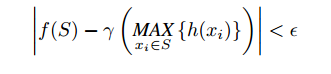

我们的想法是通过在集合中的变换元素上应用对称函数来逼近定义在点集上的一般函数:

,其中

,其中  :

:  ,

,  :

:  ;

; :

:  是一个对称函数。

是一个对称函数。

经验上,我们的基本模块非常简单:我们用多层感知器网络来近似  ,用单变量函数和最大汇集函数来组合

,用单变量函数和最大汇集函数来组合  。 这被发现通过实验很好地工作。 通过收集

。 这被发现通过实验很好地工作。 通过收集 ,我们可以学习一些f来捕获集合的不同属性。

,我们可以学习一些f来捕获集合的不同属性。

虽然我们的关键模块看起来很简单,但它具有有趣的属性(参见5.3节),并且可以在几个不同的应用程序中实现强大的性能(请参见第5.1节)。 由于我们模块的简单性,我们也可以像4.3节那样提供理论分析。

本地和全局信息汇总 上面部分的输出形成一个向量 ,这是输入集的全局签名。 我们可以轻松地训练支持分类的全局形状特征的SVM或多层感知器分类器。 但是,点分割需要结合本地和全局知识。 我们可以通过简单而高效的方式来实现这一目标。

,这是输入集的全局签名。 我们可以轻松地训练支持分类的全局形状特征的SVM或多层感知器分类器。 但是,点分割需要结合本地和全局知识。 我们可以通过简单而高效的方式来实现这一目标。

我们的解决方案可以在图2中看到(分割网络)。 在计算全局点云特征向量之后,通过将全局特征与每个点特征相连接,将其反馈给每点特征。 然后我们基于组合的点特征提取新的每点特征 - 这次每点特征都知道本地和全局信息。

通过这种修改,我们的网络能够预测依赖于局部几何和全局语义的每点数量。 例如,我们可以准确预测每点法线(附图中的图),验证网络能够汇总来自该点的当地邻域的信息。 在实验环节中,我们还展示了我们的模型可以在形状部分分割和场景分割上实现最先进的性能。

联合调整网络 如果点云经历了某些几何变换(例如刚性变换),则点云的语义标签必须是不变的。 因此,我们期望我们的点集的学习表示对这些转换是不变的。

一个自然的解决方案是在特征提取之前将所有输入集合对准典范空间。 Jaderberg等人 [9]引入了空间变换器的思想,通过采样和插值来对齐2D图像,通过在GPU上实现的专门定制的图层来实现。

与[9]相比,我们的点云输入形式使我们能够以更简单的方式实现这一目标。 我们不需要创建任何新图层,并且不会像图像案例那样引入别名。 我们通过微型网络(图2中的T-net)预测仿射变换矩阵,并将该变换直接应用于输入点的坐标。 小型网络本身类似于大型网络,由点独立特征提取,最大池和完全连接层的基本模块组成。 关于T-net的更多细节在补充中。

这个想法可以进一步扩展到特征空间的一致性。 我们可以在点要素上插入另一个对齐网络,并预测要素变换矩阵以对齐来自不同输入点云的要素。 然而,特征空间中的变换矩阵比空间变换矩阵具有更高的维度,这大大增加了优化的难度。 因此,我们为softmax培训损失增加了一个正则化术语。 我们约束特征变换矩阵接近正交矩阵:

, 其中

, 其中 是由迷你网络预测的特征对齐矩阵。 正交变换不会丢失输入中的信息,因此是理想的。 我们发现通过添加正则化项,优化变得更加稳定,并且我们的模型实现了更好的性能。

是由迷你网络预测的特征对齐矩阵。 正交变换不会丢失输入中的信息,因此是理想的。 我们发现通过添加正则化项,优化变得更加稳定,并且我们的模型实现了更好的性能。

4.3 理论分析

通用逼近 我们首先展示了神经网络对连续集函数的通用逼近能力。 通过设定函数的连续性,直观地说,对输入点集合的小扰动不应该大大改变函数值,例如分类或分割分数.

正式的, 令 是一个关于

是一个关于 的豪斯多夫距离

的豪斯多夫距离 的连续的点集函数,

的连续的点集函数, 对于任意的

对于任意的  如果

如果  ,然后

,然后 , 我们的定理说

, 我们的定理说  可以由我们的网络任意近似在最大汇集层给出足够的神经元,即

可以由我们的网络任意近似在最大汇集层给出足够的神经元,即 in(1)足够大。

in(1)足够大。

理论1 假设  是一个连续函数关于豪斯多夫距离

是一个连续函数关于豪斯多夫距离 一个连续函数

一个连续函数  和一个对称函数

和一个对称函数  , 这样对于任何

, 这样对于任何  ,

,

其中 是

是 任意结构中元素的完整列表任意地,

任意结构中元素的完整列表任意地, 是连续函数,

是连续函数, 是矢量将

是矢量将  个向量作为输入并返回

个向量作为输入并返回  的

的  运算符元素最大值的新向量。

运算符元素最大值的新向量。

这个定理的证明可以在我们的补充材料中找到。 关键的想法是,在最坏的情况下,网络可以通过将空间划分成相等大小的体素来学习将点云转换为体积表示。 然而,在实践中,网络学习了一个更加智慧的探测空间的策略,正如我们将在点函数可视化中看到的那样.

瓶颈维度和稳定性 从理论和实验上我们发现,我们网络的表现力受到最大汇聚层的维度,即(1)中的K的强烈影响。 这里我们提供一个分析,它也揭示了与我们模型的稳定性相关的属性.

我们将 ![]() 定义为将

定义为将 中的一个点集合映射到K维向量的f的子网络。 下面的定理告诉我们,输入集中的小的损坏或额外的噪声点不可能改变我们网络的输出:

中的一个点集合映射到K维向量的f的子网络。 下面的定理告诉我们,输入集中的小的损坏或额外的噪声点不可能改变我们网络的输出:

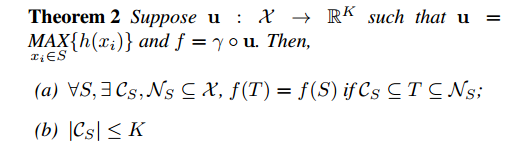

理论2

我们解释这个定理的含义。 (a)如果 中的所有点都被保留,则

中的所有点都被保留,则  保持不变直至输入损坏; 它也没有变化,额外的噪音点达到

保持不变直至输入损坏; 它也没有变化,额外的噪音点达到  。 (b)表示

。 (b)表示 仅包含有限数量的点,由(1)中的K确定。 换句话说,

仅包含有限数量的点,由(1)中的K确定。 换句话说,  实际上完全由小于或等于K个元素的有限子集

实际上完全由小于或等于K个元素的有限子集  确定。 因此,我们将

确定。 因此,我们将 称为

称为 和

和 的临界点集合,即f的瓶颈维数。

的临界点集合,即f的瓶颈维数。

5. 实验

实验分为四个部分。 首先,我们展示PointNets可以应用于多个3D识别任务(第5.1节)。 其次,我们提供详细的实验来验证我们的网络设计(5.2节)。 最后,我们可以看到网络学习的内容(5.3节)并分析时间和空间的复杂性(5.4节)。

5.1 应用

在本节中,我们将展示如何训练我们的网络来执行3D对象分类,对象部分分割和语义场景分割1。 尽管我们正在研究一种全新的数据表示(点集),但我们能够在几项任务的基准测试中实现可比较甚至更好的性能.

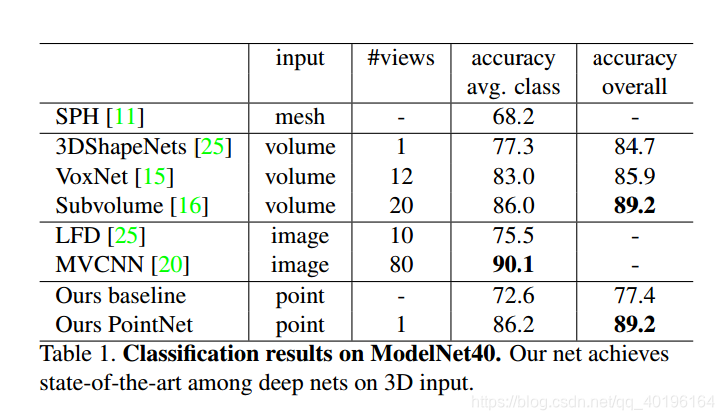

3D对象分类 我们的网络学习可用于对象分类的全局点云特征。 我们在ModelNet40 [25]形状分类基准上评估我们的模型。 来自40个人造物体类别的CAD模型共12,311个,分为9,843个培训项目和2,468个测试项目。 虽然以前的方法专注于体积和多视图图像表示,但我们是第一个直接处理原始点云的方法.

我们根据面部区域在网格面上均匀采样1024个点,并将它们归一化为单位球体。 在训练过程中,我们通过沿上轴随机旋转物体来实时增强点云,并以零均值和0.02标准偏差的高斯噪声抖动每个点的位置。

在表1中,我们将我们的模型与以前的作品以及使用MLP提取的传统特征(点密度,D2,形状轮廓等)的基线进行比较。 我们的模型在基于3D输入(体积和点云)的方法中实现了最先进的性能。 只有完全连接的层和最大池,我们的网络在推理速度方面获得了强大的领先优势,并且可以在CPU中轻松并行化。 我们的方法和基于多视图的方法(MVCNN [20])之间仍然存在一个小的差距,我们认为这是由于渲染图像捕获的精细几何细节的丢失。

3D对象部分分割 部分分割是一项具有挑战性的细粒度3D识别任务。 给定3D扫描或网格模型,任务是将部件类别标签(例如椅子腿,杯柄)分配给每个点或面。

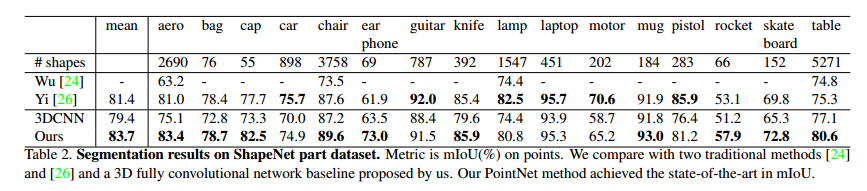

我们对来自[26]的ShapeNet零件数据集进行评估,其中包含来自16个类别的16,881个形状,总共标注了50个零件。 大多数对象类别标有2到5个部分。 地面真实注释标注在形状上的采样点上。

我们将部分分割作为每点分类问题。 评估指标以点为单位。 对于C类中的每个形状S,计算形状的mIoU:对于C类中的每个部分类型,计算groundtruth和预测之间的IoU。 如果地面实测点与预测点的联合为空,则将IoU计为1.然后,我们对C类中的所有零件类型计算IoUs,以获得该形状的MIUU。 为了计算该类别的mIoU,我们对该类别中的所有形状取平均值mIoU。

在本节中,我们将我们的分割版本PointNet(图2的修改版本,分割网络)与两种传统方法[24和26]进行比较,这两种方法都利用了形状之间的点向几何特征和对应关系,以及 我们自己的3D CNN基准。 有关3D CNN的详细修改和网络架构,请参阅补充内容。

在表2中,我们报告了每个类别和平均IoU(%)分数。 我们观察到IoU平均改善2.3%,我们的网络在大多数类别中都超过了基准方法。

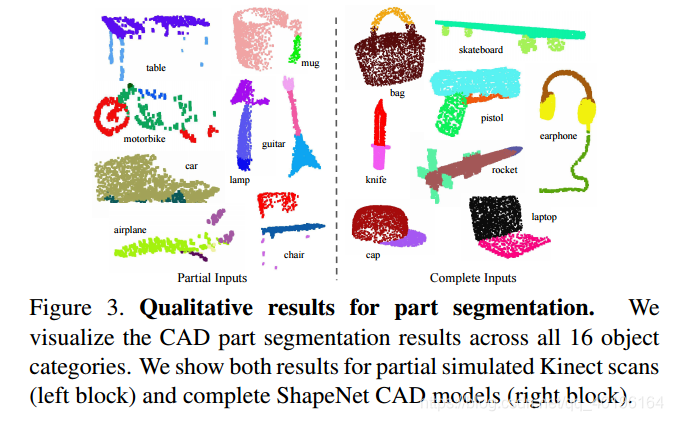

我们还对模拟Kinect扫描进行实验,以测试这些方法的稳健性。 对于ShapeNet零件数据集中的每个CAD模型,我们使用Blensor Kinect模拟器[7]从六个随机视点生成不完整的点云。 我们使用相同的网络架构和训练设置对我们的PointNet进行完整形状和部分扫描的训练。 结果显示我们的平均IoU仅损失了5.3%。 在图3中,我们给出了完整和部分数据的定性结果。 可以看到,虽然部分数据相当具有挑战性,但我们的预测是合理的。

场景中的语义分割 我们的零件分割网络可以很容易地扩展到语义场景分割,其中点标签变成语义对象类而不是对象部分标签。

我们在斯坦福3D语义分析数据集上进行实验[1]。 该数据集包含来自Matterport扫描仪的6个区域(包括271个房间)的3D扫描。 扫描中的每个点都用13个类别(椅子,桌子,地板,墙壁等)的语义标签中的一个注释加上杂乱的东西。

为了准备训练数据,我们首先按房间分开,然后将房间样品分成1m×1m的区域。 我们训练我们的PointNet分割版本,以预测每个块中的每个点类。 每个点由XYZ,RGB的9-dim向量表示,以及对于房间(从0到1)的归一化位置。 在训练时,我们随机在每个模块中随机抽样4096个点。 在测试时间,我们测试所有的点。 我们遵循与[1]相同的协议,使用k-fold策略进行训练和测试。

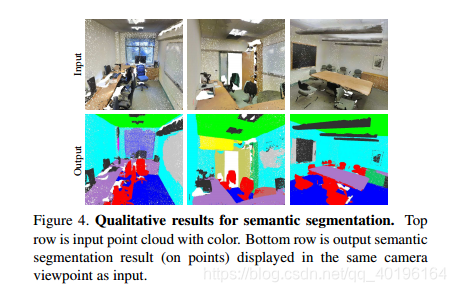

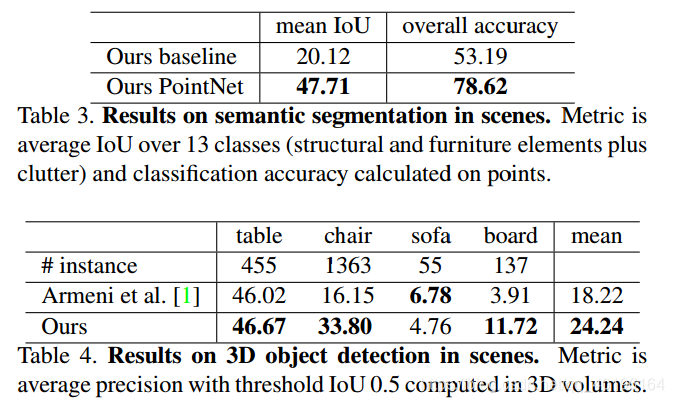

我们将我们的方法与使用手工点特征的基线进行比较。 基线提取相同的9点灰度局部特征和三点附加点:局部点密度,局部曲率和法线。 我们使用标准的MLP作为分类器。 结果显示在表3中,我们的PointNet方法明显优于基线方法。 在图4中,我们显示了定性分割结果。 我们的网络能够输出平滑的预测结果,并且对丢失点和闭塞很有效。

基于我们网络输出的语义分割,我们进一步构建了一个使用连接组件进行对象建模的3D对象检测系统(详见补充)。 我们与表4中以前的先进方法进行比较。前一种方法基于滑动形状方法(使用CRF后处理),SVM使用局部几何特征和体素格网中的全局空间上下文特征进行训练。 我们的方法在所报告的家具类别上大幅超越了它。

5.2 结构设计分析

在本节中,我们通过控制实验验证我们的设计选择。 我们还展示了我们的网络超参数的影响。

与备选顺序不变方法的比较 如4.2节所述,至少有三个选项用于消耗无序设置输入。 我们使用ModelNet40形状分类问题作为比较这些选项的测试平台,以下两个控制实验也将使用此任务。

我们比较的基线(如图5所示)包括未分类和分类点上的多层感知器作为n×3阵列,将输入点视为序列的RNN模型以及基于对称函数的模型。 我们尝试的对称操作包括最大池,平均池和基于注意力的加权和。 注意方法类似于[22]中的方法,其中从每个点要素预测标量分数,然后通过计算softmax将分数标准化到点之间。 然后在归一化分数和点特征上计算加权和。 如图5所示,maxpooling操作通过较大的赢利余量实现了最佳性能,这证实了我们的选择。

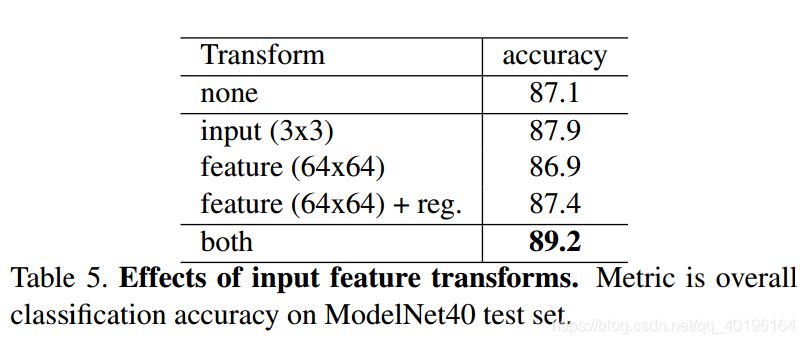

输入和特征转换的有效性 在表5中,我们展示了输入和特征变换(对齐)的积极效果。 有趣的是,最基本的架构已经取得了相当合理的结果。 使用输入转换可提高0.8%的性能。 正则化损失对于更高维度变换起作用是必要的。 通过结合变换和正则化项,我们实现了最佳性能。

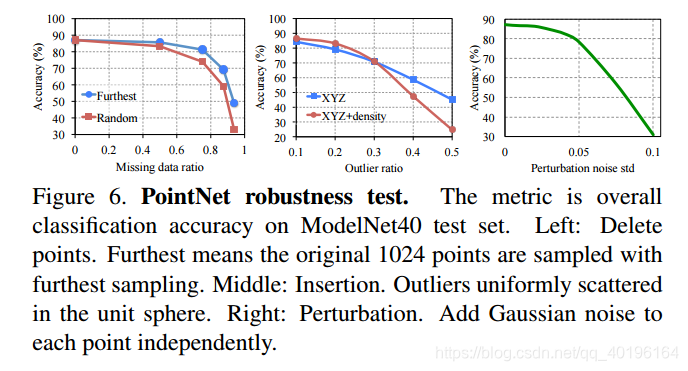

健壮性测试 我们展示了我们的PointNet,虽然简单而有效,但对各种输入损坏都很有效。 我们使用与图5的最大池网络相同的架构。 输入点标准化为单位球体。 结果在图6中。

至于缺失的点,当缺少50%的点时,精度仅下降2.4%和3.8%w.r.t. 最远和随机的输入采样。 如果在训练期间看到这些点,我们的网络对于异常点也很有效。 我们评估两个模型:一个用  坐标点进行训练; 另一个在

坐标点进行训练; 另一个在 加上点密度。 即使20%的分数是异常值,网络的准确率也超过80%。 图6右图显示了网络对点扰动的鲁棒性。

加上点密度。 即使20%的分数是异常值,网络的准确率也超过80%。 图6右图显示了网络对点扰动的鲁棒性。

5.3 可视化Pointnet

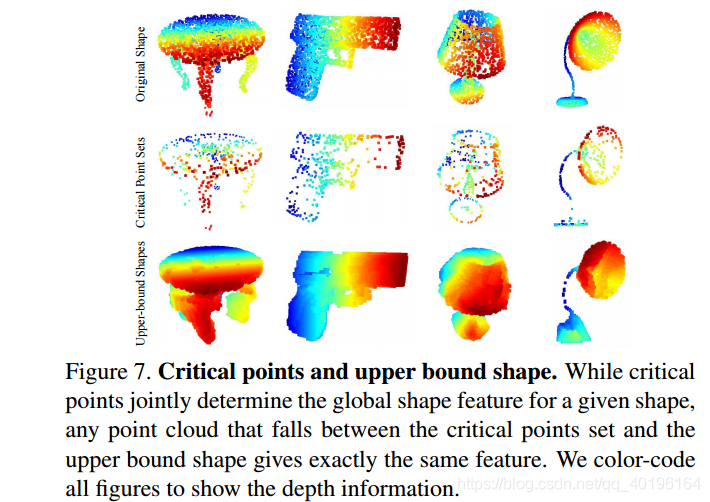

在图7中,我们将一些样本形状  的临界点集合

的临界点集合  和上限形状

和上限形状  的一些结果可视化(如在Thm 2中讨论的)。两个形状之间的点集合将给出完全相同的全局形状特征

的一些结果可视化(如在Thm 2中讨论的)。两个形状之间的点集合将给出完全相同的全局形状特征  .

.

从图7我们可以清楚地看到,临界点设置了 ,这些贡献了最大的合并特征,总结了形状的骨架。 上界形状

,这些贡献了最大的合并特征,总结了形状的骨架。 上界形状 表示给出与输入点云

表示给出与输入点云 相同的全局形状特征

相同的全局形状特征 的最大可能点云

的最大可能点云 和NS反映了PointNet的鲁棒性,这意味着丢失一些非临界点不会改变 全局形状签名

和NS反映了PointNet的鲁棒性,这意味着丢失一些非临界点不会改变 全局形状签名 。

。

是通过网络转发边长为2的立方体中的所有点,并选择点函数值

是通过网络转发边长为2的立方体中的所有点,并选择点函数值 为不大于全局形状描述符.

为不大于全局形状描述符.

5.4 时间和空间复杂度分析

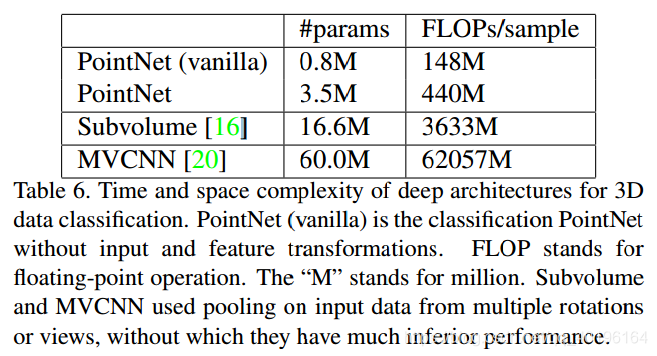

表6总结了我们分类PointNet的空间(网络中的参数数量)和时间(浮点运算/样本)复杂度。 我们还将PointNet与以前作品中基于体积和多视图的代表性体系结构进行比较。

尽管MVCNN [20]和子卷(3D CNN)[16]实现了高性能,但PointNet在计算成本方面效率更高(分别以FLOP / sample进行测量:分别为141x和8x)。 此外,就网络中#param而言,PointNet比MVCNN更节省空间(参数少17倍)。 此外,PointNet更具可扩展性 - 空间和时间复杂度为O(N) - 输入点数量呈线性。 然而,由于卷积占主导地位的计算时间,多视图方法的时间复杂度在图像分辨率上正常增长,而基于体积卷积的方法随着卷大小立方增长。

经验上,PointNet能够在TensorFlow上使用1080X GPU处理每秒超过100万点的点云分类(约1K个对象/秒)或语义分割(约2个房间/秒),显示出实时应用的巨大潜力。

6. 结论

在这项工作中,我们提出了一种新的直接消耗点云的深度神经网络PointNet。 我们的网络为许多3D识别任务提供了一个统一的方法,包括对象分类,零件分割和语义分割,同时获得比标准基准上的艺术状态更好的结果。 我们还提供理论分析和可视化,以了解我们的网络。

Acknowledgement. 作者非常感谢三星GRO授予的资助,ONR MURI N00014-13-1-0341资助,NSF资助IIS-1528025,Google聚焦研究奖,Adobe公司的礼物以及NVIDIA的硬件捐赠。

References

[1] I. Armeni, O. Sener, A. R. Zamir, H. Jiang, I. Brilakis, M. Fischer, and S. Savarese. 3d semantic parsing of large-scale indoor spaces. In Proceedings of the IEEE International Conference on Computer Vision and Pattern Recognition, 2016. 6, 7

[2] M. Aubry, U. Schlickewei, and D. Cremers. The wave kernel signature: A quantum mechanical approach to shape analysis. In Computer Vision Workshops (ICCV Workshops), 2011 IEEE International Conference on, pages 1626–1633. IEEE, 2011. 2

[3] M. M. Bronstein and I. Kokkinos. Scale-invariant heat kernel signatures for non-rigid shape recognition. In Computer Vision and Pattern Recognition (CVPR), 2010 IEEE Conference on, pages 1704–1711. IEEE, 2010. 2

[4] J. Bruna, W. Zaremba, A. Szlam, and Y. LeCun. Spectral networks and locally connected networks on graphs. arXiv preprint arXiv:1312.6203, 2013. 2

[5] D.-Y. Chen, X.-P. Tian, Y.-T. Shen, and M. Ouhyoung. On visual similarity based 3d model retrieval. In Computer graphics forum, volume 22, pages 223–232. Wiley Online Library, 2003. 2

[6] Y. Fang, J. Xie, G. Dai, M. Wang, F. Zhu, T. Xu, and E. Wong. 3d deep shape descriptor. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 2319–2328, 2015. 2

[7] M. Gschwandtner, R. Kwitt, A. Uhl, and W. Pree. BlenSor: Blender Sensor Simulation Toolbox Advances in Visual Computing. volume 6939 of Lecture Notes in Computer Science, chapter 20, pages 199–208. Springer Berlin / Heidelberg, Berlin, Heidelberg, 2011. 6

[8] K. Guo, D. Zou, and X. Chen. 3d mesh labeling via deep convolutional neural networks. ACM Transactions on Graphics (TOG), 35(1):3, 2015. 2

[9] M. Jaderberg, K. Simonyan, A. Zisserman, et al. Spatial transformer networks. In NIPS 2015. 4

[10] A. E. Johnson and M. Hebert. Using spin images for efficient object recognition in cluttered 3d scenes. IEEE Transactions on pattern analysis and machine intelligence, 21(5):433– 449, 1999. 2

[11] M. Kazhdan, T. Funkhouser, and S. Rusinkiewicz. Rotation invariant spherical harmonic representation of 3 d shape descriptors. In Symposium on geometry processing, volume 6, pages 156–164, 2003. 5

[12] Y. Li, S. Pirk, H. Su, C. R. Qi, and L. J. Guibas. Fpnn: Field probing neural networks for 3d data. arXiv preprint arXiv:1605.06240, 2016. 2

[13] H. Ling and D. W. Jacobs. Shape classification using the inner-distance. IEEE transactions on pattern analysis and machine intelligence, 29(2):286–299, 2007. 2

[14] J. Masci, D. Boscaini, M. Bronstein, and P. Vandergheynst. Geodesic convolutional neural networks on riemannian manifolds. In Proceedings of the IEEE International Conference on Computer Vision Workshops, pages 37–45, 2015. 2

[15] D. Maturana and S. Scherer. Voxnet: A 3d convolutional neural network for real-time object recognition. In IEEE/RSJ International Conference on Intelligent Robots and Systems, September 2015. 2, 5

[16] C. R. Qi, H. Su, M. Nie?ner, A. Dai, M. Yan, and L. Guibas. Volumetric and multi-view cnns for object classification on 3d data. In Proc. Computer Vision and Pattern Recognition (CVPR), IEEE, 2016. 2, 5, 8

[17] R. B. Rusu, N. Blodow, and M. Beetz. Fast point feature histograms (fpfh) for 3d registration. In Robotics and Automation, 2009. ICRA’09. IEEE International Conference on, pages 3212–3217. IEEE, 2009. 2

[18] R. B. Rusu, N. Blodow, Z. C. Marton, and M. Beetz. Aligning point cloud views using persistent feature histograms. In 2008 IEEE/RSJ International Conference on Intelligent Robots and Systems, pages 3384–3391. IEEE, 2008. 2

[19] M. Savva, F. Yu, H. Su, M. Aono, B. Chen, D. Cohen-Or, W. Deng, H. Su, S. Bai, X. Bai, et al. Shrec16 track largescale 3d shape retrieval from shapenet core55. 2

[20] H. Su, S. Maji, E. Kalogerakis, and E. G. Learned-Miller. Multi-view convolutional neural networks for 3d shape recognition. In Proc. ICCV, to appear, 2015. 2, 5, 6, 8

[21] J. Sun, M. Ovsjanikov, and L. Guibas. A concise and provably informative multi-scale signature based on heat diffusion. In Computer graphics forum, volume 28, pages 1383–1392. Wiley Online Library, 2009. 2

[22] O. Vinyals, S. Bengio, and M. Kudlur. Order matters: Sequence to sequence for sets. arXiv preprint arXiv:1511.06391, 2015. 2, 4, 7

[23] D. Z. Wang and I. Posner. Voting for voting in online point cloud object detection. Proceedings of the Robotics: Science and Systems, Rome, Italy, 1317, 2015. 2

[24] Z. Wu, R. Shou, Y. Wang, and X. Liu. Interactive shape cosegmentation via label propagation. Computers Graphics, 38:248 – 254, 2014. 6

[25] Z. Wu, S. Song, A. Khosla, F. Yu, L. Zhang, X. Tang, and J. Xiao. 3d shapenets: A deep representation for volumetric shapes. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 1912–1920, 2015. 2, 5

[26] L. Yi, V. G. Kim, D. Ceylan, I.-C. Shen, M. Yan, H. Su, C. Lu, Q. Huang, A. Sheffer, and L. Guibas. A scalable active framework for region annotation in 3d shape collections. SIGGRAPH Asia, 2016. 6