LP-3DCNN: Unveiling Local Phase in 3D Convolutional Neural Networks

代码地址:

https://sites.google.com/view/lp-3dcnn/home(400错误找不到)

关键词:

Rectified Local Phase Volume (ReLPV) block(校正局部相位体积(ReLPV)块:局部相位模块、ReLU激活函数和一组可训练线性权值组成)

ReLPV块代替3D卷积层

问题:

(1)计算量大;(2)模型尺寸大;(3)易过拟合;(4)特征学习能力有待进一步提升。

原理:

Layer 1。这一层是标准的三维卷积层,只有一个大小为1×1×1的过滤器。从上一层输入一个大小为c×d×h×w的feature map,并将其转换为一个大小为1×d×h×w的单通道feature map。

这一层为第2层计算的3D STFT操作准备输入。设f(x)为第1层的feature map输出,大小为1×d×h×w。这里,x是一个变量,表示feature map f(x)上的位置

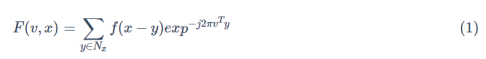

Layer 2。第2层通过公式(1)计算f(x)在局部n×n×n邻域NxNx的每个位置处的三维短时傅里叶变换(STFT),提取f(x)的局部相位谱。

v∈R3是一个频率变量,j=√-1,使用向量符号表示公式(1)

![]()

wv为频率变量v处三维STFT的基向量,fx为包含邻域Nx所有位置的向量。

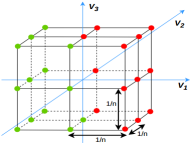

注意,由于基函数的可分性,可以对f(x)中的所有位置使用简单的一维卷积有效地计算出三维STFT。在这项工作中,考虑了13个最低的非零频率变量,定义如下。所选频率变量如图2所示为红点。

使用低频变量是因为它们通常包含大部分信息,因此它们具有比高频分量更好的信噪比。令

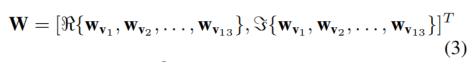

这里W是一个26×n3的变换矩阵对应于13个频率变量。R{·}和ζ{·}分别返回复数的实部和虚部。13个频率点(v1,v2,…,v13)的三维STFT矢量形式:

由于Fx是对输入f(x)的所有位置x进行计算,得到的输出特征图大小为26×d×h×w

Layer 3。使用ReLU函数,对Layer2的特征进行激活。

Layer 4。标准的3D卷积层,滤波器尺寸为尺寸为1×1×1。输入特征图尺寸为26×d×h×w,输出特征图,尺寸为f×d×h×w。

Layer 2的后向传播,没有可训练的参数,训练中,只有Layer 1和4的1×1×1滤波器更新,W中的权重不变。

ReLPV块采用两个超参数作为输入:

输入特征映射的每个位置计算STFT(并且提取局部相位)的局部体积的大小;

ReLPV块输出的特征映射的数量。

STFT:属于正交变换家族,故对输入信号进行去相关

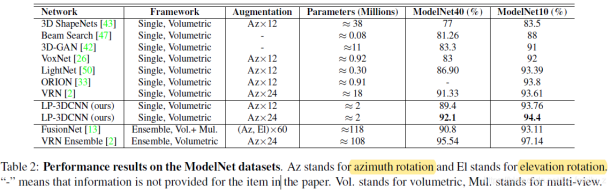

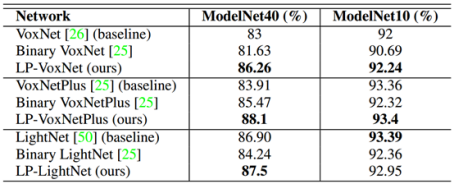

ModelNet:与最先进的技术进行比较

遵循(VRN)体系结构的思想该体系结构采用简单的inception风格的体系结构和resnet风格的跳过连接。

图(a):连接两个具有不同局部相位体积大小(3×3×3和5×5×5)的ReLPV块的相同数量(128)的特征图

图(b):允许网络在对前一层中的特征图的加权平均(对1×1×1卷积进行大量加权) 或者 本地相位信息(通过对ReLPV块进行大量加权)之间进行选择。添加跳过连接,以使梯度更平滑地流向先前的层。

图(c):最终模型图

优点:

降低传统三维神经网络的高时空复杂度和模型复杂度。

只使用了200万个参数,而目前最先进的VRN网络使用了1800万个参数,占用更少的磁盘空间。

由于基函数的可分性,可以通过对每个维使用简单的一维卷积有效地计算STFT,可以降低计算成本

缺点:

拥有最复杂的网络架构,多达45层,1.08亿个参数,需要近6天的时间来训练。

创新点:

1)提出了ReLPV块,有效替代了标准3D卷积层。ReLPV块显著地减少了可训练参数的数目,与标准3D卷积层相比,滤波器尺寸分别为3×3×3~13×13,至少减少了33~133倍。

2)在ModelNet10和ModelNet40数据集上实现了最先进的精度。另外,提供了在时空图像序列上的结果。另:在UCF-101 split-1动作识别数据集上,在仅使用15%的最新参数的同时,将当前的技术水平提高了5.68%。

3)改变ReLPV块的各种超参数,对其进行了消融和性能研究

实验结果:

ModelNet:与基线的比较

Conv3D:标准3D卷积;MP:最大池数;FC:全连接层,类别数

Voxnet:conv3D(5,32,2)?conv3D(3,32,1)?MP(2)?FC(128)?FC(K)

LPvoxnet:ReLPV(5,32,2)?ReLPV(3,32,1)?MP(2)?FC(128)?FC(K)

SGD作为优化器,动量为0.9,

分类交叉熵为损失,

对这些新网络进行训练,学习率从0.008开始,每次降低2倍

ModelNet:与最先进的技术进行比较

输入是ModelNet数据集中大小为32×32×32的体素,

SGD作为优化器,动量为0.9,

分类交叉熵为损失。

学习率0.008开始,如果验证损失稳定,则将其减少5倍,

正交初始化初始化所有权重

首先在Az×12增强数据上训练网络,然后以低学习速率对Az×24增强数据进行微调