Abstract

在本文中,我们提出了一种用于人在地平面上跟踪的协作式雷达/摄像机融合方法。 使用平均人员身高,通过将摄像机的检测反投影到雷达距离-角坐标系上,计算了joint detection likelihood。 代表候选目标的联合似然峰值将馈入粒子过滤器跟踪器。 根据关联结果,使用关联的检测(通过检测进行跟踪)或通过采样原始可能性本身(在检测之前进行跟踪)来更新粒子。 利用原始似然数据的优势在于,即使摄像机或RADAR信号低于检测阈值,也可以连续跟踪丢失的目标。

我们表明,在单一目标,无杂波的环境中,所提出的方法完全优于仅使用相机的跟踪。 在现实世界的城市环境中进行的实验还证实,即使在困难和模棱两可的情况下,协作式融合跟踪器也能产生明显更好的估计

Introduction

在本文中,我们提出了一种用于目标检测和跟踪的混合低级和高级协作融合架构。 通过连续调整一个传感器的低级运行特性(通过另一个传感器或更高级的信息)来完成协作传感器融合。

每个人的状态由一组随机的样本——粒子表示,它们的权重和位置允许灵活地利用低级传感器信息

初始地面平面检测是通过将摄像机检测反投影到原始RADAR范围/方位角信号(图1和图2c上的紫色)而获得的。

接下来,将代表预期候选目标中心的局部峰值馈入多目标跟踪器中。 可以与现有轨道关联的候选目标通过目标轨道候选(图1中的蓝色)更新各自的状态,而未关联的轨道使用在图像检测之前的传感器(雷达?)观测值进行更新。

因此,在数据关联良好的情况下,跟踪器从数据峰值中获得的歧义信息较少(less ambiguous likelihood information),而在歧义情况下(ambiguous situations),跟踪器更新了整个能量场的采样,其中多个弱目标可以更新多个未关联的轨道。

我们的混合方法本质上是用于良好数据关联的“按检测跟踪”设计,以及在无法建立关联时在检测之前进行跟踪(TBD)。

Tracking by cooperative fusion

我们提出的系统基于这些论文的TBD理念,可以从一辆移动车辆中追踪多个多个软目标。

我们提出了一种基于粒子滤波的多目标跟踪器,该跟踪器使用神经网络[9]进行初始目标检测。然后将这些检测结果与RADAR数据融合,以形成潜在目标的联合RADAR-Vision可能性(joint RADAR-Vision likelihood)。

在跟踪预测期间,使用联合似然函数更新粒子权重,同时将检测到的目标用于创新现有轨道或创建新轨道。 因此,在跟踪过程中,丰富的雷达信息得到了充分利用。

[7]中的作者对行人运动使用恒定速度模型,而我们从[10]中采用了行为运动模型。 我们使用匈牙利算法[11]解决数据关联问题,同时使用类似于[12]的马尔可夫决策过程方法完成轨道管理。

形式上,系统的目标是通过使用过去和当前的传感器信息最大化对状态的置信度来估计未知目标集合X的状态和目标数量。

我们将目标建模为地平面上的随机变量,并在空间x∈R 4中具有四个参数(位置和速度); x = [x,y,x,˙y˙] T

该系统依靠一组传感器Y = {YC,YR,…}来扫描车辆周围的环境以寻找潜在的碰撞威胁。

RADAR传感器以3D数据的形式生成观测值:范围,(径向)速度和方位:yR∈R 3

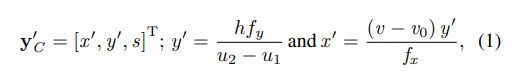

相机产生框

平面不兼容,投影到框上

s是图像直接输出? h是平均身高,fx,fy,v0是相机内参

具体来说,如果轨迹是预测的而不是未更新,我们将在运行NMS和CFAR前,将使用原始可能性更新粒子权重。

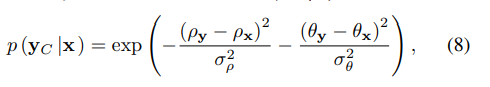

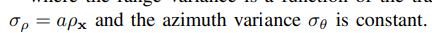

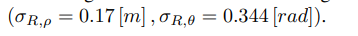

多个因素影响投影精度,令检测不确定。因此在极坐标系近似了一个二维的高斯分布,径向和角度方差是范围的函数

模型中人高不正确会产生接地平面误差,该误差与距离成线性比例,可以很好地捕获

与其他道路使用者和基础设施相比,由于人们的雷达截面较大,因此我们试图从数据立方体中提取的有用信号

首先,以大于最大明确速度的速度运动的对象会出现混叠并显示为重影

其次,在现实世界的交通环境中,RADAR信号会受到多径传播的影响,如果不了解现场情况就很难建模

最后,当两个人彼此靠近站立且没有事先知道目标数目的信号时,就会有强烈的信号混合,很难解决问题。

为了减少似然函数的计算量,我们在极坐标模拟中使用二维高斯函数对RADAR观测似然度进行建模。

也建立了两个高斯

banana型的

Experimental Result

为了捕获数据,我们为电动货运三轮车配备了一个传感器阵列,该传感器阵列包括一个GoPro Hero 4黑色RGB摄像机,德州仪器(TI)AWR1443 77GHz汽车FMCW雷达和Velodyne VLP-16 LiDAR。

分别以30Hz,20Hz和10Hz异步捕获数据,同时使用时间戳实现同步。

通过校准的VLP-16 LiDAR得出的相对于地面真实情况的估计人员位置在地平面位置上的均方根误差来衡量性能

显然,以绿色点表示的相机错误模式在纵向方向上更为明显,而以红色点表示的RADAR误差在横向方向上更强。

我们选择了16个交通困难的序列,自我运动的范围从0Km / h到25Km / h。 所有序列均由计算机视觉研究人员手动注释,以使注释者被要求在LiDAR,RADAR和Camera数据中均可见的每个易受伤害的道路使用者周围绘制地面边界框。 注释者还可以提前过去或将来的时间,以便准确标记不明确的案例。 数据集总共包含以10Hz捕获的1922个帧,以及6734个标记为d真实对象

跟踪器[10]解决了关联问题,并决定是更新现有轨道,生成新轨道还是合并轨道。 我们输出的轨迹达到χt> 0.7的置信度分数,然后使用门控最近邻关联将其与地面真相注释进行比较

应用了2m的门控,这意味着结果仅与2m内的地面真相注释匹配。 在这些门中,我们对照仅照相机的跟踪器来计算协同融合跟踪器的RMSE。 在表I中,我们提供了每个序列和每个范围括号的结果的完整细分。 我们观察到在纯相机和融合实验中,定位精度都会随着距离的增加而降低

Conclusion

在地面上可以精确地检测和跟踪目标,并且可以在路径规划算法中使用跟踪预测。 在CFAR算法选择候选目标之前,使用原始的RADAR-摄像机联合观察可能性更新粒子样本权重。,跟踪器便可以使用丰富的似然信息来连续更新粒子权重。 该操作原理在概念上与经典的“检测跟踪”不同,并且能够更好地利用低电平传感器信息。

设计与传感器数据紧密耦合的跟踪器有其缺点。 在检测之前,粒子滤波器需要评估联合似然函数,这意味着RADAR处理器必须评估范围/方位角/多普勒数据上的所有粒子假设。 这会产生内存开销,该开销与目标数量和粒子数量成线性比例。 为了减轻这个问题并仍然保留实时操作能力,我们使用高级Quasar编译器和编程语言在CUDA中实现了所有跟踪和似然计算代码[17]。 在我们实际的城市环境实验中,我们为跟踪算法测量的平均运行时间为每帧52.9毫秒。 这次不包括可以卸载到单独的GPU的CNN对象检测和CFAR算法。 该方法的潜在弱点是在相机反投影期间假设平均人物身高。 这会导致相机的距离估计值出现较大差异,并且如果非平均身高的人会造成歧义。 我们未来的研究将集中于将人的身高纳入状态向量