论文地址:https://arxiv.org/abs/1704.02447

code:https://github.com/xingyizhou/pytorch-pose-hg-3d

Towards 3D Human Pose Estimation in the Wild: a Weakly-supervised Approach

Xingyi Zhou1,2, Qixing Huang2, Xiao Sun3, Xiangyang Xue1, Yichen Wei3

在野外进行3D人体姿态估计:一种弱监督方法

摘要

在本文中,我们研究了野外三维人体姿态估计的任务。 由于缺乏训练数据,此任务具有挑战性,因为现有数据集要么是具有2D姿势的野生图像,要么是具有3D姿势的实验室图像。

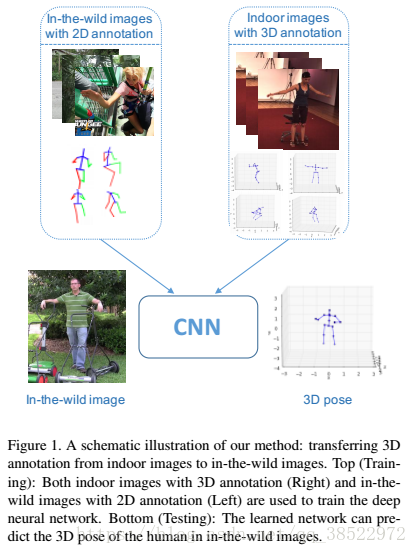

我们提出了一种弱监督转移学习方法,该方法在统一的深中性网络中使用混合的2D和3D标签,呈现两级级联结构。 我们的网络通过3D深度回归子网络增强了最先进的2D姿态估计子网络。 与之前的按顺序和分开训练两阶段方法不同,我们的训练是两个子网络端到端并充分利用2D姿态和深度估计子任务之间的相关性。 通过共享表示可以更好地学习深层特征。 在这样做时,受限制的实验室环境中的3D姿势标签被转移到野外图像中。 此外,我们引入了3D几何约束来规范3D姿态预测,这在没有地面实况深度标签的情况下是有效的。 我们的方法在2D和3D基准测试中实现了有竞争力的结果。

- 简介

人体姿势估计问题已在计算机视觉中得到了大量研究。 它在人机交互,虚拟现实和动作识别方面有许多重要的应用。 现有的研究工作分为两类:2D姿态估计和3D姿态估计。 由于大规模2D标注人体姿势的可用性和深度神经网络的出现,2D人体姿势估计问题最近取得了巨大的成功[17,29,11,4,7]。 最先进的技术能够在各种设置中实现准确的预测(例如,野外图像[2])。

相比之下,3D人体姿势估计的进步仍然有限。 部分原因是由于从单个图像恢复3D信息的模糊性,还有一部分原因是由于缺少大规模3D姿势标注数据集。 准确的说,还没有针对野外图像的全面的3D人体姿势数据集。 常用的3D数据集[12,24]由受控实验室环境中的mocap系统获取。 在这些数据集上训练的深度神经网络[13,33]并不能很好地推广到其他实例,例如在野外。

mocap系统解释了解:https://www.jianshu.com/p/5b35493c386f

https://zhuanlan.zhihu.com/p/37415840

在野外已经有很多关于3D人体姿势估计的工作。 它们通常按两个连续步骤进行[34,26,5,3,30,31]。 第一步估计2D关节位置[17,29,11]。 第二步从这些2D关节[21,32,1]恢复3D姿势。 这两个步骤的训练是分开进行的。 即,从野外的2D标注训练2D姿势预测,并且从现有的3D MoCap数据训练来自2D关节的3D姿势恢复。 这样的顺序流水线显然是次优的,因为在第二步中丢弃了包含用于3D姿势恢复的丰富提示的原始野外2D图像信息。

最近,Mehta等人。 [15]已经表明,2D到3D知识转移,即使用预训练的2D姿势网络来初始化3D姿势回归网络可以显着改善3D姿势估计性能。 这表明2D和3D姿势估计任务固有地纠缠在一起并且可以共享共同的表示

受这项工作的启发,我们认为反向知识边缘转移,即从室内图像的3D注释到野外图像,为野外3D姿态预测提供了有效的解决方案。 在这项工作中,我们引入了一个统一的框架,可以利用野外图像中的2D注释作为3D姿势估计任务的弱标签。 换句话说,我们考虑一个弱监督的转移学习问题,其中源域由受限室内环境中的完全注释图像组成并且目标域由野外的弱标记图像组成。

与之前的作品类似[34,26,5,3,30,31],我们的网络也包括2D模块和3D模块。 然而,我们的方法不是仅仅将2D模块的输出作为输入提供给3D模块,而是将3D模块与2D模块的中间层连接起来。 这允许我们共享2D和3D任务之间的共同表示。 该网络是同时具有2D和3D数据端到端的训练。 这使我们的工作与所有现有工作区别开来。

为了更好地规范弱监督3D姿态估计的学习,我们引入了用于训练3D模块的几何约束。 几何约束基于以下事实:人体骨骼中的相对骨骼长度保持近似固定。 当将来自室内环境中的标记图像的3D姿势信息适应于野外的未标记图像时,实验验证了该约束的有效性。

这项工作做出以下贡献:

我们首次提出了一种用于野外图像的端到端3D人体姿势估计框架。 它在几个基准测试中实现了最先进的性能。

我们从仅具有2D联合注释的图像中提出了用于3D姿态估计的3D几何约束。其具有低内存和计算成本。 它改善了估计姿势的几何有效性。

- 相关工作

人类姿势估计在过去已被大量研究[16,23],并且提供文献的完整概述超出了本文的范围。 在本节中,我们将重点放在以前关于3D人体姿态估计的工作上,这些工作与本文的背景最为相关。 我们还将讨论关于对训练神经网络施加弱/无监督约束的相关工作

3D人体姿势估计。 给定良好标记的数据(例如,人类骨骼的3D关节位置[12,24]),可以将3D人体姿势估计公式化为标准的监督学习问题。 一种流行的方法是训练神经网络直接回归关节位置[13]。 最近,人们已经将这种方法推广到不同的方向。 Zhou等人。 [33]建议明确执行预测中的骨长度约束,使用生成的前向运动层; Tekin 等人。 [25]在网络顶部嵌入了一个预训练的自动编码器。 与之相反,Pavlakos等人引入了一种3D方法,该方法回归了3D骨架的体积表示[19]。 尽管标准3D姿态估计基准数据集的性能提高,但由于自然图像与这些基准数据集所使用的特定捕获环境之间的区域差异,所得到的网络不会推广到野外图像。

解决三维人体姿势估计数据集与野外图像之间的域差异的标准方法是将任务分成两个单独的子任务[34,26,5,3,30]。第一个子任务估计2D关节位置。该子任务可以利用任何现有的2D人体姿势估计方法(例如,[17,29,11,4]),并且可以从野外图像的数据集中进行训练。第二个子任务回归这些2D关节的3D位置。由于此步骤的输入仅是一组2D位置,因此可以在任何基准数据集上训练3D姿态估计网络,然后在其他设置中进行调整。关于来自2D关节位置的3D姿态估计,[34]使用EM通过组合由2D热图引起的稀疏字典来计算3D骨架的算法; [30,19]使用3D姿势数据及其2D投影来训练没有原始图像的热图到3D姿势网络; Bogo等。 [3]优化线性3D人体模型[14]的姿势和形状项,以最佳地拟合其2D投影;陈等人。 [5]使用最近邻搜索将估计的2D姿势与3D姿势以及可以从大型3D姿势库产生类似2D投影的相机视图相匹配;最后是Tome等人。 [26]提出了预训练的概率3D姿势模型层,首先生成合理的3D人体模型从2D热图,然后通过改进这些热图结合3D姿势投影和图像功能。所有这些

然而,方法有一个共同的局限:3D姿势仅从2D关节估计,已知2D关节产生模糊结果。相比之下,我们的方法可以利用2D关节位置以及原始图像的中间特征代表。

3D人体姿态估计的另一种方法是从合成数据集中进行训练,这些数据集是通过使用已知的3D地面实况变形人体模板模型而生成的[6,22]。 这确实是一种可行的解决方案,但基本挑战是如何对3D环境进行建模,以使合成图像的分布与自然图像的分布相匹配。 事实证明,沿着这条线的最先进的方法在自然图像上的竞争力较弱。

还有其他利用混合2D和3D数据进行3D人体姿势估计的工作。 Mehta等。 [15]使用3D数据微调预训练的2D姿态估计网络。 Popa等人。 [20]将3D人体姿态估计视为具有不同数据的2D和深度回归的多任务学习。 我们与那些使用弱监督损失的工作不同,这些损失无缝地集成了两个2D和统一框架中的3D数据。

弱/非监督约束。在训练数据不足的情况下,在预测中加入通用或弱监督约束可以作为提高性能的有力工具。这种想法通常用于图像分类或分割。 Pathak等人。 [18]提出了一种约束优化框架,该框架利用对标签概率之和的线性约束来进行弱监督语义分割。 Tzeng等。 [28]提出了域混淆损失,以最大化两个数据集之间的混淆,从而鼓励域不变特征。最近,Hoffman等人。 [10]引入基于对抗性学习的全局域对齐方法,并利用弱标签约束在野外应用完全连接的网络。在本文中,我们展示了这个一般概念也可以用于姿势估计。据我们所知,我们的方法是第一个利用几何引导约束来规范野外图像的姿态估计网络。

3.方法

3.1。概观

给定包含人类对象的RGB图像,我们的目标是估计3D人体姿势Y∈Y3D,由人体骨骼的一组3D关节坐标表示,即Y3D∈RJ×3,其中J是关节的数量。 我们遵循在与I相关联的局部相机坐标系中表示每个3D坐标的惯例,即,前两个坐标由图像像素坐标(定义相应的2D关节位置)给出,第三个坐标是关节深度。 度量坐标,例如,这项工作中的毫米。

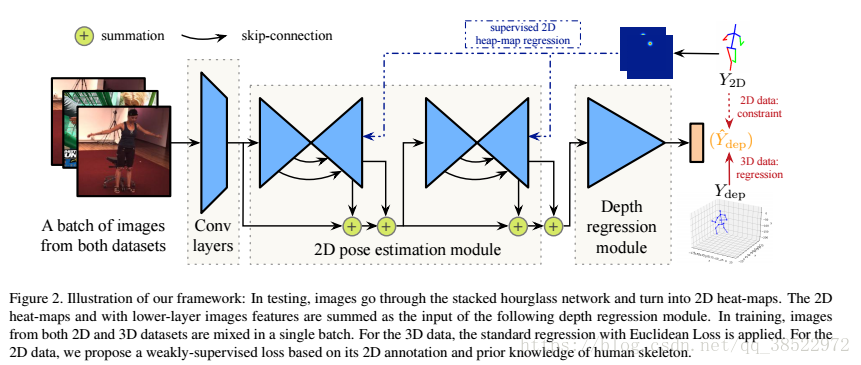

我们提出的网络架构如图2所示。它由2D姿态估计模块(第3.2节)和深度回归模块(第3.3节)组成。 他们预测2D关节位置Y2D∈Y2D,其中Y2D RJ×2和深度值Ydep∈Ydep,其中Ydep RJ×1分别。 最终输出是Y2D和Ydep的串联。

网络是通过实验室中的两个图像训练的,具有3D地面实况(对于Y2D和Ydep)和野外图像,仅具有2D地面实况(对于Y2D)。 在本文的提醒中,3D和2D训练图像集分别表示为I3D和I2D。

3.2。 2D姿态估计模块

我们采用[17]中最先进的沙漏网络架构作为我们的2D姿态估计模块。 网络输出是一组J低分辨率热图。 每个地图YHM∈RH×W表示一个关节的2D概率分布。 2D姿势Y2D∈Y2D中的预测关节是这些热图上的峰值位置。 这种热图表示很方便,因为它可以很容易地组合

(连接或求和)与其他深层特征图,例如,如图2所示

为了训练这个模块,损失函数是

损耗测量预测的热图YHM与通过高斯核[17]从地面实况Y2D渲染的热图G(Y2D)之间的L2距离。

3.3。 深度回归模块

与仅从2D关节预测[21,32,1]恢复3D关节位置的先前方法相比,我们的方法在(i)用于端到端网络训练的2D和3D模块的集成以及(ii)方面进行了创新。 )使用3D几何约束引起的损失。 它们在下面详细说明。

集成2D和3D模块。 深度估计的关键问题是如何有效地利用图像特征。 先前[34,26,5]中广泛使用的策略是将2D关节位置作为深度预测的唯一输入,因为这样可以利用仅Mocap数据。 然而,该策略本质上是模糊的,因为通常存在单个2D骨架的多个3D解释。 我们建议在2D中结合2D联合热图和中间特征表示模块作为深度回归模块的输入。 这些为2D姿态估计提取多个级别的语义信息的特性为3D姿势恢复提供了额外的线索。 这种共享的共同特征学习对我们的方法至关重要。

三维几何约束引起的损失。 深度学习的一个挑战是如何整合完全标记和弱标记的图像。 对于完全注释的3D数据集S3D = {I3D,Y2D,Ydep},训练损失可以简单地是使用地面实况深度标记的标准欧几里德损失。 对于弱标记的数据集S2D = {I2D,Y2D},我们提出了由几何约束引起的新的损失。 在没有地面实况深度标签的情况下,该几何约束用作深度预测的有效正则化。

总的来说,让Ydep表示预测的深度。 深度回归模块的损失是:

其中λreg和λgeo是相应的损失权重

Lgeo(Ydep | Y2D)是建议的几何损失。 这是基于以下事实:骨长度之间的比率在人体骨骼中保持相对固定(例如,上/下臂具有固定的长度比,左/右肩骨共享相同的长度)。

具体地,令Ri是骨架组i中的一组涉及的骨骼,例如, Rarm = {左上臂,左下臂,右上臂,右下臂},让le为骨e的长度,让le表示规范骨架中骨e的长度(在我们的实验中,它是设定的 作为人类3.6M数据集的所有训练科目的平均值)。 每组Ri中每个骨e的比率应保持固定。 建议的损失测量每个Ri的{le le}e∈Ri之间的方差之和:

注意,骨骼长度是关节位置的函数,而关节位置又是预测深度的函数。 因此,Lgeo相对于Ydep是连续且可微分的。 补充材料中提供了前向和后向方程的数学细节。还要注意,Lgeo定义在地面实况2D位置Y2D而不是预测的2D位置Y2D。 这使得训练更容易,因为没有向2D模块的反向传播。

在我们的实验中,我们考虑4组骨骼:Rarm = {左/右下/上臂},Rleg = {左/右下/上腿},Rshoulder = {左/右肩骨},Rhip = {左/ 右臀骨}。 我们发现它们在躯干上不包括骨骼,因为我们发现它们在不同的人体形状上表现出相对较高的骨骼长度变化,这使得我们的约束不那么有效。 注意骨骼不同集合不会相互影响。

3.4。 训练

结合方程式中的损失。 (1),(2)和(3),每个训练图像I I2D∪I3D的总损失是:

随机梯度下降优化用于训练。 类似于[28]和[10],每个小批量包含2D和3D训练样例(半个半),它们是随机抽样的

在实验中,我们发现从头开始对整个网络的直接端到端训练效果不佳,可能是因为两个模块之间的依赖性和新几何约束引起的损失的高度非线性特性。 因此,我们提出了一个三阶段的训练计划,我们发现它在实践中更加稳定和有效。 请注意,最后阶段是端到端的。

阶段1使用2D注释图像初始化2D姿势模块,如[17]中所述。 阶段2初始化3D姿势估计模块并微调2D姿势估计模块。 使用2D和3D注释数据。 通过设置λgeo= 0 in,不激活几何约束公式2.第3阶段使用所有数据对整个网络进行微调。 几何约束被激活。

4.实验评估

为了验证我们的方法,使用Human3.6M数据[12]和MPII数据[2]训练单个模型。 评估在三个不同的测试数据集上进行。

评估来自两个方面:监督的3D人体姿势估计(第4.2节)和在野外转移的3D人体姿势估计(第4.3节)。

定性结果总结在表中。 5.关于MPII验证集的更多定性结果可以在补充材料中找到。

4.1。 实验装置

4.1.1实施细节

我们的方法是用torch7实现的[8]。 沙漏组件基于[17]中的公共代码。 为了快速训练,我们使用浅叠版沙漏,即每个沙漏用2个叠加2个残余模块[9]。 深度回归模块包含4个连续的残差和汇集模块,可以视为半沙漏。 相同的网络架构和培训在我们的所有实验中都使用迭代。

第3.4节中的第一个训练阶段花费了240k,批量为6.这给了我们一个2D姿态估计模块,其性能与[17]中相似。 阶段2和阶段3分别进行了200k和40k迭代。 整个训练过程在一个Titan X GPU中花了大约两天时间使用CUDA 8.0和cudnn 5.测试中的正向传递大约是30ms。 我们设置λreg= 0.1和λgeo= 0.01。 我们按照[17]设置了所有其他超参数。

4.1.2数据集和度量标准

MPII训练。 MPII数据集[2]用于训练。 它是一个大规模的野外人体姿势数据集。 从在线视频收集图像并由人注释J = 16个2D关节。 它包含25k个训练图像和2957个验证图像[27]。 人类受试者用边界框注释。 我们使用MPII的训练集来训练2D姿势估计模块。 它也提供了弱点监督深度回归模块。

Human3.6M。人类3.6M数据集[12]用于训练和测试。它是用于3D人体姿势估计的广泛使用的数据集。该数据集包含由MoCap系统在室内环境中捕获的360万个RGB图像。我们将视频从50f ps下采样到10f ps,用于训练和测试集,以减少冗余。遵循[13,34,33]中的标准协议,

我们使用5个科目(S1,S5,S6,S7,S8)进行训练,其余2个科目(S9,S11)进行测试。评估度量是在对齐根关节的深度之后的每个关节位置误差(MPJPE)的平均值。我们使用其投影的2D位置来训练2D模块及其深度回归模块的深度注释。

我们使用训练中数据集中提供的地面实况2D关节位置(因此隐式使用相机校准信息)来对齐3D和2D姿势。在测试期间,通过要求所有3D骨骼长度的总和等于预定义规范骨架的总和,不需要这样的校准,如[19,35]中所做的那样。转换配方如下:

其中Yout是组合的2D和深度3D关节,它是网络的输出; SumLenout是计算出的输出关节的骨架长度; 和AvgSumLen是一个常数,它被计算为人类3.6M数据集中所有训练对象的平均骨架长度和

MPI-INF-3DHP。 MPI-INF-3DHP [15]是新提出的3D人体姿势数据集。 这些图像由MoCap系统在室内和室外场景中捕获。 我们只使用其测试集拆分进行评估。 测试集包含来自6个主题的2929个有效帧,执行7个动作。 在[15]之后,我们采用平均PCK(阈值为150mm)和AUC作为评估指标,即对齐根关节(骨盆)后。 请注意,我们假设全球范围已知用于实验评估。 我们观察到MPI-INF-3DHP中骨盆位置的定义与我们训练集中使用的定义不同(即人体3.6M和MPII),因此我们将骨盆和臀部以固定比例(0.2)移向颈部 作为我们评估中的后期处理。

MPII验证。 虽然MPII数据集不提供3D姿势注释,但我们在评估中使用其验证子集[27]有两个目的。 它包含训练集中的2958个野外图像。

首先,我们提供定性的3D姿势估计结果。其中许多看起来似乎合理且令人信服。 在补充材料中查看更多信息

其次,我们仍然可以评估估计的3D姿势的几何有效性,这可以通过我们提出的约束来改进。 我们使用对称骨骼长度的差异(例如,左上臂和右上臂)作为评估度量。 为了计算度量,我们将2D关节标准化为256×256像素(以便可以在输入图像中直接绘制预测的关节)。 深度按相同比例标准化。 然后,我们计算左右对称骨骼之间的L1距离,例如, 对于上臂,它是|| Y(左肩)Y(左手弯)|| || Y(右肩)Y(右肘)|||。 此度量标准适用于MPI-INF-3DHP数据集和MPII验证集,以评估我们提出的弱监督几何损失的有效性

4.1.3消融研究的基线

我们实施了三种基线方法,并以与提出的方法相同的方式训练基线模型。

3D / wo geo它只使用3D标记的数据来训练Sec的Stage2和Stage3中的网络。3.4。 不使用野外图像。 请注意,2D沙漏模块是在Stage1中的2D数据集上预先训练的。

3D / w geo它将几何约束引起的损失添加到第一个基线中。

3D + 2D / wo geo与提出的方法的唯一区别在于,在训练3D模块时,几何约束不用于2D标记数据。

所提出的方法表示为3D + 2D / w geo。

4.2。 监督3D人体姿态估计

我们首先报告和分析我们的方法在Human 3.6M数据集上的表现[12]。

基线比较。 表1将提出的方法与三个基线进行了比较。 基线3D / wo geo的平均MPJPE为82.44mm。 这已经与大多数最先进的方法相比[33,26,35]。 请注意,此基线与Metha等人类似。 [15],用3D数据微调2D姿态网络[11]进行信息传递。 不同之处在于我们没有对转移的层使用1000×学习率衰减,在我们的情况下产生了更差的性能。

添加几何约束,即3D / w geo,提供了不错的性能增益。

使用2D和3D数据(3D + 2D / wo geo)进行训练,可显着提高性能 - 平均MPJPE降至64.90mm,优于之前的所有工作[15,19]。这验证了在我们的统一培训中组合数据源的有效性。

最后,提出的方法3D + 2D / w geo实现了最佳结果。请注意,约束应用于不相交的2D数据集,表明所提供的先验知识是通用的。我们还测试了对完全监督的3D数据的添加约束。结果是相似的。

与其他野外方法进行比较。我们的方法优于适用于野外图像的其他方法。与两个两步法相比,Chen和Ramanan [5]的MPJPE为114.18mm,周等人的MPJPE。 [35]是79.9毫米。 Pavlakos等。 [19]提供了一种替代的解耦版本,也可以在野外应用,但其MPJPE增加到78.1mm。 MPJPE我们的方法是64.90mm,明显更好。

为什么结合2D和3D数据更好? 一个合理的问题是,目前尚不清楚组合训练的好处是来自更好的深度估计,还是来自更准确的2D姿态估计。

为了回答这个问题,我们仅使用标准度量PCKh@0.5评估2D姿态估计的准确性(见[2])。 Tab中的结果。 图2示出了在所有三个基线和所提出的方法中2D姿势非常准确。 这令人信服地表明,将2D数据添加到训练中并不能提高2D精度,但主要通过共享深度特征表示使深度回归模块受益。

4.3。 在野外转移人类姿势

我们评估了我们的方法在不同的野外环境中捕获的两个数据集的推广。

4.3.1 MPI-INF-3DHP数据集

它表现出来自MPII和Human 3.6M数据集的相当大的域转移。 表3比较了各种方法对MPI-INF-3DHP的性能。 在这种情况下,前两种基线方法,即3D / wo geo和3D / w geo,具有低性能。 这并不奇怪,因为3D训练集仅包含室内图像。 我们注意到即使在这种情况下,几何约束仍然有效(3D / wo geo比3D / w geo更糟糕。

3D + 2D / wo geo分别在PCK和AUC中达到65.8和32.1。 这些数字在人类3.6M训练数据[15]中优于同等数据(64.7 PCK和31.7 AUC),再次显示了我们训练计划的优势。

提出的方法在PCK中产生69.2,在AUC中产生32.5。 这些数字接近于MPI-INF-3DHP [15]的原始训练数据,其中PCK为72.5,AUC为36.5。 即使我们没有使用他们的训练数据,我们的结果仍然很强。 这证实了我们的方法对野外图像的能力。

我们还测试了左右对称性,如第二节所述。4.1.2。 结果见表。 4(底部)显示使用几何约束显着提高了几何有效性

4.3.2 MPII验证数据集

最后,我们在最具挑战性的野外MPII验证集上评估我们的方法。 表5中的定性3D姿势结果非常合理。

几何有效性。 如第二节所述。 4.1.2,我们评估左右对称度量。 表4(上图)中的结果表明我们的方法要好得多。

2D精度与3D精度。 我们注意到我们的方法具有比原始沙漏模型略低的2D关节精度。 这可以预期,因为我们的模型学习了额外的深度回归任务。 然而,利用几何约束也改善了2D关节精度。 这表明我们的网络能够将这种几何约束从3D模块传播到2D模块,这证明了我们网络的设计目标

。

5.未来的工作和结论

在本文中,我们介绍了一种端到端系统,该系统结合了野外的2D姿态标签和受限环境中的3D姿势标签,以应对野外3D人体姿态估计的挑战问题。 在未来,我们计划探索更多的非/弱监督约束以实现更好的传输,例如[10,28]中的域对齐网络。 我们希望这项工作可以激发更多关于非/弱监督转移学习和野外3D人体姿势估计的工作。

致谢

我们感谢Dushyant Mehta和Helge Rhodin帮助评估MPI-INF-3DHP数据集,并感谢Danlu Chen对图2的帮助。另外,我们感谢Wei Zhang的有益讨论。 这项工作部分得到了国家自然科学基金(#U1611461,#61572138),上海市科学技术委员会(#16JC1420401)的支持。

参考文献

[1] I. Akhter and M. J. Black. Pose-conditioned joint angle lim?its for 3d human pose reconstruction. In Proceedings of theIEEE Conference on Computer Vision and Pattern Recognition, pages 1446–1455, 2015. 2, 4

[2] M. Andriluka, L. Pishchulin, P. Gehler, and B. Schiele. 2d human pose estimation: New benchmark and state of the art analysis. In IEEE Conference on Computer Vision and Pat?tern Recognition (CVPR), June 2014. 1, 5, 7

[3] F. Bogo, A. Kanazawa, C. Lassner, P. Gehler, J. Romero,and M. J. Black. Keep it smpl: Automatic estimation of 3d human pose and shape from a single image. In European Conference on Computer Vision, pages 561–578. Springer,2016. 2

[4] A. Bulat and G. Tzimiropoulos. Human pose estimation via convolutional part heatmap regression. In European Conference on Computer Vision, pages 717–732. Springer, 2016. 1,2

[5] C.-H. Chen and D. Ramanan. 3d human pose estimation= 2d pose estimation+ matching. arXiv preprint arXiv:1612.06524, 2016. 2, 4, 6, 7

[6] W. Chen, H. Wang, Y. Li, H. Su, Z. Wang, C. Tu, D. Lischin?ski, D. Cohen-Or, and B. Chen. Synthesizing training images for boosting human 3d pose estimation. In 3D Vision (3DV),2016 Fourth International Conference on, pages 479–488.IEEE, 2016. 3

[7] X. Chu, W. Yang, W. Ouyang, C. Ma, A. L. Yuille, and X. Wang. Multi-context attention for human pose estimation. arXiv preprint arXiv:1702.07432, 2017. 1

[8] R. Collobert, K. Kavukcuoglu, and C. Farabet. Torch7: A matlab-like environment for machine learning. In BigLearn, NIPS Workshop, 2011. 5

[9] K. He, X. Zhang, S. Ren, and J. Sun. Deep residual learning for image recognition. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 770–778, 2016. 5

[10] J. Hoffman, D. Wang, F. Yu, and T. Darrell. Fcns in the wild: Pixel-level adversarial and constraint-based adaptation. arXiv preprint arXiv:1612.02649, 2016. 3, 4, 8

[11] E. Insafutdinov, L. Pishchulin, B. Andres, M. Andriluka, and B. Schiele. Deepercut: A deeper, stronger, and faster multiperson pose estimation model. In European Conference on Computer Vision, pages 34–50. Springer, 2016. 1, 2, 6

[12] C. Ionescu, D. Papava, V. Olaru, and C. Sminchisescu. Human3.6m: Large scale datasets and predictive methods for 3d human sensing in natural environments. IEEE Transactions on Pattern Analysis and Machine Intelligence, 36(7):1325–1339, jul 2014. 1, 2, 5, 6

[13] S. Li and A. B. Chan. 3d human pose estimation from monocular images with deep convolutional neural network. In Asian Conference on Computer Vision, pages 332–347. Springer, 2014. 1, 2, 5

[14] M. Loper, N. Mahmood, J. Romero, G. Pons-Moll, and M. J. Black. Smpl: A skinned multi-person linear model. ACM Transactions on Graphics (TOG), 34(6):248, 2015. 2

[15] D. Mehta, H. Rhodin, D. Casas, O. Sotnychenko, W. Xu,and C. Theobalt. Monocular 3d human pose estimation using transfer learning and improved cnn supervision. arXiv preprint arXiv:1611.09813, 2016. 2, 3, 5, 6, 7

[16] T. B. Moeslund and E. Granum. A survey of computer vision-based human motion capture. Computer vision and image understanding, 81(3):231–268, 2001. 2

[17] A. Newell, K. Yang, and J. Deng. Stacked hourglass net?works for human pose estimation. In European Conference on Computer Vision, pages 483–499. Springer, 2016. 1, 2, 4,5

[18] D. Pathak, P. Krahenbuhl, and T. Darrell. Constrained convolutional neural networks for weakly supervised segmentation. In Proceedings of the IEEE International Conference on Computer Vision, pages 1796–1804, 2015. 3

[19] G. Pavlakos, X. Zhou, K. G. Derpanis, and K. Daniilidis. Coarse-to-fine volumetric prediction for single-image 3d human pose. arXiv preprint arXiv:1611.07828, 2016. 2, 5, 6,7

[20] A.-I. Popa, M. Zanfir, and C. Sminchisescu. Deep multitask architecture for integrated 2d and 3d human sensing. arXiv preprint arXiv:1701.08985, 2017. 3

[21] V. Ramakrishna, T. Kanade, and Y. Sheikh. Reconstructing 3d human pose from 2d image landmarks. In European Conference on Computer Vision, pages 573–586. Springer, 2012.2, 4

[22] G. Rogez and C. Schmid. Mocap-guided data augmentation for 3d pose estimation in the wild. In Advances in Neural Information Processing Systems, pages 3108–3116, 2016. 3

[23] N. Sarafianos, B. Boteanu, B. Ionescu, and I. A. Kakadiaris. 3d human pose estimation: A review of the literature and analysis of covariates. Computer Vision and Image Under?standing, 152:1–20, 2016. 2

[24] L. Sigal, A. O. Balan, and M. J. Black. Humaneva: Synchronized video and motion capture dataset and baseline algorithm for evaluation of articulated human motion. International journal of computer vision, 87(1-2):4, 2010. 1, 2

[25] B. Tekin, I. Katircioglu, M. Salzmann, V. Lepetit, and P. Fua.Structured prediction of 3d human pose with deep neural networks. arXiv preprint arXiv:1605.05180, 2016. 2

[26] D. Tome, C. Russell, and L. Agapito. Lifting from the deep:Convolutional 3d pose estimation from a single image. arXiv preprint arXiv:1701.00295, 2017. 2, 4, 6

[27] J. Tompson, R. Goroshin, A. Jain, Y. LeCun, and C. Bregler. Efficient object localization using convolutional networks. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 648–656, 2015. 5

[28] E. Tzeng, J. Hoffman, T. Darrell, and K. Saenko. Simultaneous deep transfer across domains and tasks. In Proceedings of the IEEE International Conference on Computer Vision,pages 4068–4076, 2015. 3, 4, 8

[29] S.-E. Wei, V. Ramakrishna, T. Kanade, and Y. Sheikh. Convolutional pose machines. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 4724–4732, 2016. 1, 2

[30] J. Wu, T. Xue, J. J. Lim, Y. Tian, J. B. Tenenbaum, A. Torralba, and W. T. Freeman. Single image 3d interpreter network. In European Conference on Computer Vision, pages 365–382. Springer, 2016. 2

[31] H. Yasin, U. Iqbal, B. Kruger, A. Weber, and J. Gall. A dual?source approach for 3d pose estimation from a single image.In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 4948–4956, 2016. 2

[32] X. Zhou, S. Leonardos, X. Hu, and K. Daniilidis. 3d shape estimation from 2d landmarks: A convex relaxation approach. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 4447–4455, 2015. 2,4

[33] X. Zhou, X. Sun, W. Zhang, S. Liang, and Y. Wei. Deep kinematic pose regression. In Computer Vision–ECCV 2016 Workshops, pages 186–201. Springer, 2016. 1, 2, 5, 6

[34] X. Zhou, M. Zhu, S. Leonardos, K. G. Derpanis, and K. Daniilidis. Sparseness meets deepness: 3d human pose estimation from monocular video. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 4966–4975, 2016. 2, 4, 5

[35] X. Zhou, M. Zhu, G. Pavlakos, S. Leonardos, K. G. Derpanis, and K. Daniilidis. Monocap: Monocular human motion capture using a cnn coupled with a geometric prior. arXiv preprint arXiv:1701.02354, 2017. 5, 6, 7