1、准确率与召回率(Precision & Recall)

准确率和召回率是广泛用于信息检索和统计学分类领域的两个度量值,用来评价结果的质量。其中精度是检索出相关文档数与检索出的文档总数的比率,衡量的是检索系统的查准率;召回率是指检索出的相关文档数和文档库中所有的相关文档数的比率,衡量的是检索系统的查全率。

- 若一个实例是正类,但是被预测成为正类,即为真正类(True Postive TP)

- 若一个实例是负类,但是被预测成为负类,即为真负类(True Negative TN)

- 若一个实例是负类,但是被预测成为正类,即为假正类(False Postive FP)

- 若一个实例是正类,但是被预测成为负类,即为假负类(False Negative FN)

针对每个预测,分别统计TP(预测答案正确),FP(错将其他类预测为本类),FN(本类标签预测为其他类标)。

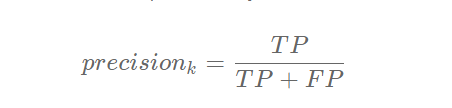

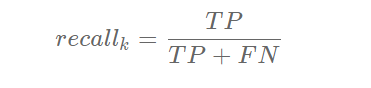

- 准确率

- 召回率

两者取值在0和1之间,数值越接近1,查准率或查全率就越高。

举个栗子:

某个湖中有1000条草鱼, 500只小龙虾, 500只甲鱼。现在假设我们以捕获草鱼为目标,每一次捕捉都是有放回的(保证各个种类数量不变)。

-

第一次捕捉到(放回),800条草鱼, 200只小龙虾, 300只甲鱼,那么指标为:

precision = 800 / (800 + 200 + 300) = 800 / 1300 ≈ 61.54%

recall = 800 / 1000 = 80% -

第二次将所有的草鱼、小龙虾、甲鱼全部捕捉上来,指标为:

precision = 1000 / (1000 + 500 + 500) = 1000 / 2000 = 50%

recall = 1000 / 1000 = 100%

此可见,正确率是评估捕获的成果中目标成果所占得比例;召回率,顾名思义,就是从关注领域中,召回目标类别的比例

2、综合评价指标(F-Measure)

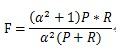

P和R指标有时候会出现的矛盾的情况,这样就需要综合考虑他们,最常见的方法就是F-Measure(又称为F-Score)

F-Measure是Precision和Recall加权调和平均:

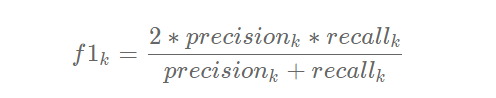

当参数α=1时,就是最常见的F1:

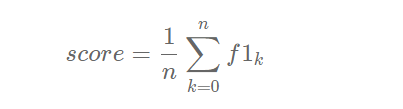

如果类别为多类,则F1-score 求均值:

F值,则是综合这二者指标的评估指标,用于综合反映整体的指标。分类比赛都是以F1作为指标的。

3.平均正确率(Average Precision, AP)

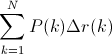

在这一积分中,其中p代表Precision ,r代表Recall,p是一个以r为参数的函数。

实际上这一积分极其接近于这一数值:对每一种阈值分别求(Precision值)乘以(Recall值的变化情况),再把所有阈值下求得的乘积值进行累加。公式如下:

在这一公式中,N代表测试集中所有图片的个数,P(k)表示在能识别出k个图片的时候Precision的值,而 Delta r(k) 则表示识别图片个数从k-1变化到k时(通过调整阈值)Recall值的变化情况。

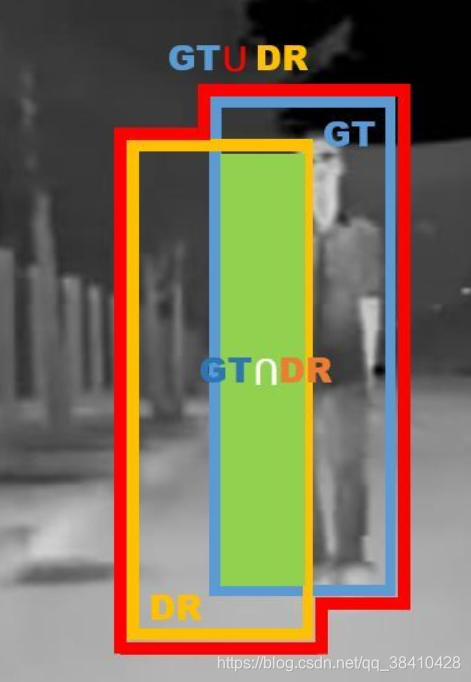

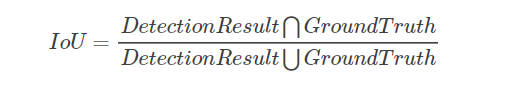

IoU

IoU这一值,可以理解为系统预测出来的框与原来图片中标记的框的重合程度。

计算方法即检测结果Detection Result与 Ground Truth 的交集比上它们的并集,即为检测的准确率:

如下图所示:

蓝色的框是:GroundTruth

黄色的框是:DetectionResult

绿色的框是:DetectionResult ? GroundTruth

红色的框是:DetectionResult ? GroundTruth