个人认为本文的思想很好,要将个性化引入到Transformer中*(NLP的各种技术在我看来其目的是明确的,一句话是什么意思就是什么意思,所以只考虑这一句话中的word即可,但是对于RS来说,同样item id的序列对于不同的user id也是不一样的,不能单纯的以 item id序列来表示一个user)*;本文主要的点有:

- 序列中 user emb和item emb进行拼接的表示

- 如何使用SSE

1 INTRODUCTION

SASRec使用标准的Transformer,本质上是一个非个性化的模型。SASRec指出增加了user emb之后效果会下降,本文认为是其已经使用了user的history items,user emb只会导致过拟合。本文提出了个性化Transformer,SSE-PT,将个性化引入了自注意网络。

3 METHODOLOGY

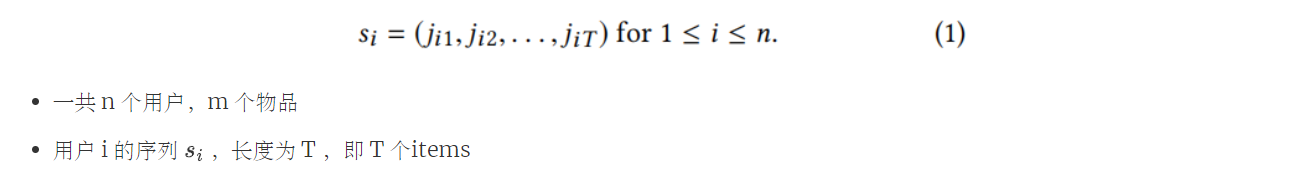

3.1 序列推荐

3.2 个性化Transformer架构

3.3 处理长序列:SSE-PT++

4 EXPERIMENTS

注意力机制可视化

一个用户早期看各种类型;随后只看戏剧和恐怖片;最近常看戏剧

一个用户早期看各种类型;随后只看戏剧和恐怖片;最近常看戏剧

- SASRec推荐出来的种类更多,倾向于所有的item

- SSE-PT推荐出来的更倾向于最近的item